Sammanfattning

Image-to-Video AI använder djupinlärningsteknik baserad på diffusionsmodeller för att omvandla statiska bilder till dynamiska videor. Till skillnad från ren text-till-video-generering behöver du bara ladda upp ett fotografi för att AI ska kunna generera realistiska rörelser, kamerarörelser och tidsmässigt sammanhängande filmsekvenser runt omkring det, vilket ger dig mer precis kontroll över det slutliga resultatet. Denna guide täcker omfattande: de tekniska principerna bakom Image-to-Video AI; vilka typer av bilder som ger optimala resultat; en praktisk handledning i fem steg för att skapa din första video från grunden; åtta praktiska användningsfall med snabba exempel; avancerade tekniker för rörelsekontroll; och en verklig jämförelse av vanliga verktyg år 2026 (inklusive de som är direkt tillgängliga i Kina). Prova Image-to-Video AI gratis -->

TuSheng Video AI tar dina stillbilder och genererar naturtrogna rörelser, filmiska kamerarörelser och tidsmässig kontinuitet – och förvandlar en enda bildruta till ett filmiskt videoklipp.

Vad är Tusheng Video AI?

Bild-till-video-AI är en artificiell intelligens-teknik som kan generera videor från statiska bilder. Du tillhandahåller ett fotografi – vare sig det är ett porträtt, en produktbild, ett landskap eller ett konstverk – och AI-modellen producerar en kort video där elementen börjar röra sig, kameravinklarna skiftar och hela scenen kommer till liv.

I grunden använder de flesta generativa videosystem videodiffusionsmodeller. Dessa neurala nätverk tränas på miljontals par av videobilder och data, och lär sig det statistiska sambandet mellan statiska bildrutor och efterföljande naturliga rörelser. När modellen presenteras för en ny bild förutsäger den vilken rörelse som verkar mest naturlig och genererar en kontinuerlig sekvens av bildrutor som smidigt övergår från det ursprungliga fotografiet.

Skillnader från text till video

Text-to-Video genererar innehåll helt utifrån text. AI:n skapar samtidigt både visuellt innehåll och rörelse baserat på din textprompt – en kraftfull men oförutsägbar process, eftersom AI:n självständigt bestämmer motivens utseende, scenernas komposition och alla typer av rörelser.

Tusheng Video vänder upp och ner på denna logik: du tillhandahåller det visuella ankare. AI:n vet redan hur scenen ser ut, eftersom du har visat den direkt. Dess enda uppgift är att generera trovärdiga rörelser. Detta innebär:

- Bättre kontroll: Dina bilder definierar motiv, komposition, färgpalett och stil

- Mindre gissningar: AI kräver ingen tolkning av vaga textbeskrivningar

- Förbättrad konsistens: Resultaten överensstämmer väl med källbilderna

- Snabbare iterationer: Det är mycket enklare att justera rörelseprompten än att skriva om hela scenbeskrivningen

Varför TuSheng Video är så viktigt år 2026

TuSheng Video AI har utvecklats från ett experimentellt leksak till ett produktivt verktyg. E-handelsvarumärken omvandlar produktbilder till animerade annonser, innehållsskapare ger liv åt sina mest populära inlägg, fastighetsmäklare producerar virtuella visningsvideor från fastighetsfoton och lärare animerar illustrationer i läroböcker.

Denna teknik har nått en vändpunkt – 5 till 15 sekunder långa videoklipp som genereras från högkvalitativa källbilder är nu i de flesta fall praktiskt taget omöjliga att skilja från traditionellt filmmaterial. Det är just därför som konvertering av bilder till video har blivit den snabbast växande kategorin inom AI-videogenerering.

Denna trend är särskilt uttalad på den kinesiska marknaden. Algoritmer på plattformar som Douyin, Xiaohongshu, Bilibili och Kuaishou gynnar alla i hög grad videoinnehåll, vilket skapar en oöverträffad efterfrågan bland kreatörer på verktyg som snabbt konverterar fotografier till videor. Tusheng Video AI fyller precis denna lucka på marknaden.

Tekniska principer för Tusheng Video AI

Att förstå den tekniska processen hjälper dig att uppnå bättre resultat. När du vet varför AI beter sig på ett visst sätt kan du ge bättre input och skriva mer effektiva uppmaningar. Här är den fyrstegsprocess som sker bakom kulisserna.

De fyra stegen i Tusheng Videos AI-bearbetningsprocess: bildkodning, rörelseprediktion, bildgenerering och tidsmässig utjämning.

Steg ett: Bildkodning

AI analyserar först din inmatade bild genom ett kodningsnätverk och komprimerar den till en tät matematisk representation som kallas latent vektor. Detta kan förstås som att AI extraherar ett "fingeravtryck" av din bild – och fångar dess struktur, färg, djup, motivets placering, ljusriktning och semantisk information.

Denna latenta representation är betydligt mer kompakt än den ursprungliga pixeldatan, vilket gör efterföljande beräkningar möjliga. Kvaliteten på kodningen påverkar direkt utdata. Högupplösta, skarpare ingångsbilder genererar rikare latenta representationer, vilket i slutändan ger överlägsen videoutdata.

Steg två: Rörelseprognos

Detta är den kreativa kärnan i hela processen. Diffusionsmodellen förutsäger vilken typ av rörelse som skulle se naturlig ut baserat på din originalbild, med hänsyn till:

- Scenisk kontext: Ett havsfoto antyder att vågorna ska slå in, ett porträtt antyder subtila ansiktsrörelser.

- Djupinformation: Objekt som är närmare linsen kan uppvisa andra rörelsemönster än objekt som är längre bort.

- Fysisk realism: Hår ska fladdra i vinden, vatten ska rinna nedåt och tyg ska falla naturligt

- Din textprompt: Om du anger "panorera långsamt åt vänster" kommer modellen att justera sin rörelseprognos därefter.

Modellen förvränger inte bara pixlar. Den genererar helt nytt visuellt innehåll för områden som nyligen exponerats genom kamerarörelser eller objektrörelser. Om kameran panorerar åt höger kommer modellen att "fylla i" scenen bortom den ursprungliga bildens högra kant.

Steg tre: Ramgenerering

Baserat på rörelseprediktion genererar modellen en sekvens av videoramar. Varje ram produceras genom en omvänd diffusionsprocess – med utgångspunkt från brus förfinas den gradvis till en klar bild samtidigt som den bibehåller konsistensen med den föregående ramen och originalbilden.

Seedance 2.0 och andra moderna modeller genererar med höga bildfrekvenser (24–30 fps) samtidigt som de bibehåller subpixelkonsistens mellan bildrutorna. Detta garanterar en jämn, flimmerfri utgång utan de ryckiga bilder som var vanliga i tidigare system.

Steg fyra: Tidsutjämning

Det sista steget säkerställer sömlösa övergångar mellan alla genererade bildrutor. Den tidsmässiga uppmärksamhetsmekanismen verifierar att ljusstyrka, färg och rörelse förblir konsekventa genom hela videon, vilket förhindrar vanliga visuella artefakter:

- Plötsliga färgförändringar mellan bildrutor

- Oväntat uppträdande eller försvinnande av objekt

- Onaturlig acceleration eller retardation av rörelser

- Flimmer i ytstrukturen

Slutresultatet är en utsökt video som flyter naturligt från det ursprungliga filmmaterialet.

Varför ser vissa bilder bättre ut?

Nu förstår du varför kvaliteten på ingångsbilden är så viktig. En suddig bild med låg upplösning ger en brusig potentiell kodning i det första steget, vilket ger mindre information till rörelseprediktionsmodellen (det andra steget). Detta resulterar i mindre precisa rörelser och fler visuella artefakter i den slutliga utgången. Omvänt ger en skarp, välkomponerad bild med tydliga djupindikationer modellen rik information, vilket resulterar i en mer naturlig video av högre kvalitet.

Vilken typ av bild ger bäst resultat?

Alla bilder är inte lämpliga för TuSheng Video AI. Skillnaden mellan bra källmaterial och dåligt källmaterial kan mycket väl vara skillnaden mellan en fantastisk video och en hög med oanvändbart filmmaterial. Här är en praktisk guide.

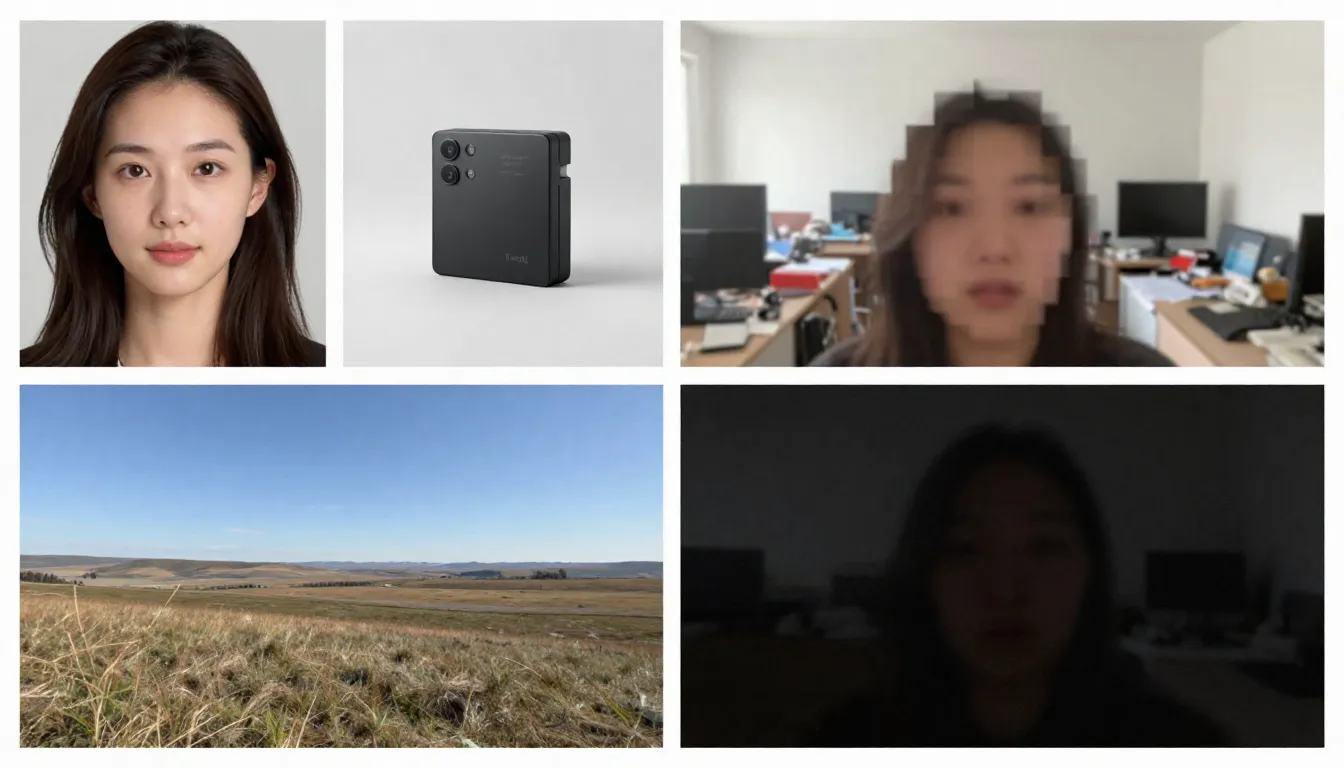

Den vänstra sidan visar lämpliga stockbilder (hög upplösning, välkomponerade, som förmedlar naturliga rörelser), medan den högra sidan visar olämpliga stockbilder (suddig, rörig, innehåller element som är svåra för AI att bearbeta).

Lämpliga bildtyper

Hög upplösning (1024x1024 eller högre). Fler pixlar gör det möjligt för kodaren att extrahera fler detaljer. Använd alltid den version med högst upplösning som finns tillgänglig. Rekommenderat minimum: 512x512 pixlar. Idealiskt: 1024x1024 eller högre.

Motiven är tydligt definierade med distinkta konturer. AI:n måste kunna urskilja vad som ska röra sig och vad som ska förbli statiskt. Ett porträtt där motivet är skarpt avgränsat från bakgrunden ger betydligt bättre resultat än en komplex, kaotisk gruppbild.

Väl upplyst och korrekt exponerad. Bilder med bra belysning ger korrekt information om färg och djup för modellen. Undvik bilder som är kraftigt överexponerade eller underexponerade.

Naturlig skiktning och komposition. Bilder med tydlig förgrund, mellanplan och bakgrund ger AI djupinformation, vilket förbättrar realismen i parallaxeffekter och kamerarörelser.

Bilder som antyder rörelse. Bilder som antyder rörelse – hår som blåser i vinden, vågor som är på väg att slå mot stranden, en person som tar ett steg – ger modellen en kraftfull utgångspunkt för att förutsäga rörelse. AI kan förstå "vad som händer härnäst" utifrån dessa visuella ledtrådar.

Rena bakgrunder. En minimalistisk eller naturligt suddig bakgrund ger en jämnare videoutgång än en rörig bakgrund fylld med många små objekt.

Bildtyper som kan orsaka problem

Suddig eller oskarp bild. Suddig inmatning, suddig utmatning. AI kan inte lägga till skärpa som inte fanns i originalbilden.

Alltför komplexa scener. Bilder som innehåller många små motiv, intrikata mönster eller visuellt röriga element kan överbelasta rörelseprediktionsmodellerna, vilket gör att de inte kan avgöra vad som ska röra sig och hur.

Omfattande text eller typografi. AI-videomodeller har fortfarande svårt att bibehålla textens läsbarhet över olika bildrutor. Om dina bilder innehåller logotyper, varumärken eller textöverlägg kommer det att uppstå förvrängningar i videoutmatningen.

Låg upplösning (512x512 eller lägre). Små bilder innehåller otillräcklig information. Även att förstora dem med AI innan de matas in är meningslöst – det lägger till pixlar men inte information.

Kraftiga filter eller efterbearbetning. Extrema färgjusteringar, HDR-bearbetning eller omfattande Photoshop-modifieringar kan förvirra modellens förståelse av belysning och djup.

Flera ansikten i olika storlekar. AI hanterar enskilda porträtt effektivt. Gruppbilder med ansikten på olika avstånd ger ojämna animationer – vissa ansikten ser naturliga ut, medan andra blir förvrängda.

Checklista för självkontroll före uppladdning

Innan du laddar upp bilder, kontrollera snabbt följande punkter:

- Minsta upplösning på 1024x1024 pixlar

- Motiv tydligt definierat med tydlig separation från bakgrunden

- Korrekt exponering (varken underexponerad eller överexponerad)

- Inga kraftiga filter, extrem HDR eller synlig artificiell bearbetning

- Minimalt med text, logotyper eller typografiska element

- Kontrollerad scenkomplexitet (1–3 huvudmotiv)

- Bildformat: JPG, PNG eller WebP

När dessa villkor är uppfyllda kan produktionen påbörjas.

Steg-för-steg-guide: Skapa din första bild-till-video

Följ dessa fem steg för att omvandla vilken statisk bild som helst till en animerad AI-video. Vi använder Seedance som demonstrationsplattform, men dessa principer gäller för alla verktyg som omvandlar bilder till video.

Steg ett: Välj lämpliga källbilder

Källbilden är den viktigaste faktorn som avgör utskriftskvaliteten. Välj en bild som uppfyller de riktlinjer som beskrivs ovan. För ditt första försök rekommenderar vi att du väljer ett enkelt porträtt eller ett landskap med tydlig djup – dessa två typer av bilder ger de mest konsekventa resultaten.

Rekommenderade bilder för första försöket:

- Tydligt porträtt eller halvlängdsporträtt i bra belysning

- Landskap med himmel, vattenytor eller vegetation (dessa element har en inneboende rörelse)

- Produktbilder mot ren bakgrund

- Konstverk eller illustrationer med tydligt definierade element

När du genererar för första gången bör du undvika att använda komplexa sammansatta bilder, bilder som innehåller stora mängder text eller kraftigt redigerade fotografier.

Steg två: Ladda upp till Seedance

Öppna Seedance Image-to-Video och ladda upp dina valda bilder. Seedance stöder formaten JPG, PNG och WebP. Plattformen analyserar automatiskt dina bilder och förbereder dem för generering.

Om en bild är exceptionellt stor (med någon sida som överstiger 4096 pixlar) kommer systemet automatiskt att skala den samtidigt som proportionerna bibehålls, vilket eliminerar behovet av manuell justering.

Steg tre: Skapa en handlingsinriktad uppmaning

I detta skede informerar du AI om önskad rörelse. Din uppmaning bör beskriva dynamiken snarare än bildens innehåll (AI har redan sett bilden). Fokusera på följande punkter:

- Motivets rörelse: Vad ska motivet göra?

- Kamerans rörelse: Hur ska kameran röra sig?

- Miljöns rörelse: Vilken dynamik ska miljön ha?

- Tempo och stämning: Övergripande tempo – snabbt eller långsamt?

Exempel på porträttfrågor:

The woman slowly turns her head to the right and smiles softly.

A gentle breeze moves her hair. Background slightly out of focus

with subtle bokeh movement. Camera slowly pushes in from medium

shot to a close-up. Warm, natural lighting. Cinematic film quality.Exempel på landskapsfråga:

Gentle waves roll toward the shore in slow motion. Clouds drift

slowly across the sky from left to right. Sunlight shimmers on

the water surface. Camera slowly pans right, revealing more of

the coastline. Peaceful, serene atmosphere. 4K cinematic quality.Exempel på produktmeddelande:

The camera slowly orbits around the product, rotating 45 degrees

clockwise. Soft studio lighting with subtle caustic reflections

on the surface. Clean white background with gentle gradient.

Premium commercial aesthetic. Smooth, steady camera movement.Grundprincip: Beskriv rörelsen, inte scenen. Scenen finns redan i din bild.

Observera: Seedance stöder både kinesiska och engelska kommandon, men engelska kommandon ger vanligtvis större precision i kamerarörelsekontrollen. Det rekommenderas att använda engelska för rörelse- och kamerarelaterade beskrivningar, medan kinesiska kan användas för atmosfäriska och stilistiska signaler.

Steg fyra: Välj parametrar

Konfigurera genereringsinställningar:

| Parameter | Rekommenderat värde | Beskrivning |

|---|---|---|

| Modell | Seedance 2.0 | Optimal bildkvalitet för generering av bild till video |

| Varaktighet | 5 sekunder (för initiala försök) | Börja kort, sedan längre; generera förlängda versioner när du är nöjd |

| Bildförhållande | Matcha bildens dimensioner | 16:9 för liggande, 9:16 för stående, 1:1 för kvadratisk |

| Upplösning | 1080p | Välj alltid den högsta tillgängliga upplösningen |

Avancerad teknik: Skapa först en 5 sekunders version. Om rörelsen och stilen är tillfredsställande, använd samma prompt för att skapa en längre version (8–15 sekunder). Denna metod sparar krediter under utforskningsfasen.

Steg fem: Generera, kontrollera, upprepa

Klicka på Generera och vänta i 1–3 minuter. När resultaten visas utvärderar du dem enligt följande kriterier:

- Är rörelsen naturlig och flytande?

- Är motivet visuellt konsekvent genom hela filmen?

- Stämmer kamerarörelsen överens med dina förväntningar?

- Finns det några visuella brister (flimmer, förvrängning, deformation)?

- Stämmer videokvaliteten överens med originalfilmen?

Om någon aspekt visar sig vara otillfredsställande, justera prompten och generera om. Vanliga justeringsmetoder är:

- För snabbt? Lägg till "långsamt", "försiktigt", "gradvis" i beskrivningen av rörelsen

- Fel kamerariktning? ** Ange tydligare: "statisk kamera, ingen kamerarörelse" eller "långsam dolly in"

- Ansiktsfel? Förenkla rörelsen: minska antalet åtgärder som utförs samtidigt

- **Brist på dynamik? ** Använd dynamiska verb: "svajande", "flödande", "drivande", "förskjutande"

Efter två eller tre omgångar av iterationer får du en högkvalitativ video som ger liv åt dina bilder.

Börja skapa din första bild-till-videoklipp nu -->

8 viktiga tillämpningar och exempel på storskalig konvertering av bilder till video

TuSheng Video AI är inte en engångsföreteelse. Den kan användas för dussintals kreativa och kommersiella ändamål. Nedan följer åtta värdefulla tillämpningsscenarier, komplett med praktiska tips som kan kopieras och modifieras direkt.

- Porträttanimation

Ge liv åt dina foton. Portrait Animation är den mest populära appen för att omvandla foton till video. Ladda upp din profilbild, selfie eller karaktärsbild och lägg sedan till subtila, verklighetstrogna animationer – andning, blinkningar, huvudrörelser, uttrycksförändringar och hårrörelser.

Lämpligt för minnesvideor, innehåll på sociala medier, skapande av virtuella avatarer och kreativ berättande. På TikTok och Xiaohongshu är innehåll som "ger liv åt fotografier" fortfarande en populär trafikmagnet.

Ett statiskt porträtt förvandlas till en verklighetstrogen video – naturliga blinkningar, subtila huvudrörelser och flödande hår, effekten är förvånansvärt verklighetstrogen.

Exempel på uppmaning:

The person looks directly at the camera with a calm, confident

expression. They slowly tilt their head slightly to the left and

give a subtle warm smile. Eyes blink naturally. A soft breeze gently

moves their hair. Shallow depth of field with softly blurred

background. Warm natural lighting. Cinematic portrait quality.- Produktpresentation

Förvandla produktfotografi till dynamiskt kommersiellt innehåll. Detta är revolutionerande för e-handelsvarumärken och influencers – du har redan hundratals eller till och med tusentals produktbilder, och nu kan var och en av dem bli en videoreklam, en viktig bild för produktdetaljsidor eller en kortfilm för sociala medier.

På produktinformationssidorna på Taobao och JD.com, i produktpresentationer i Douyins livestream och i Xiaohongshus produktrekommendationer uppnår dynamiska produktvisningar genomgående betydligt högre konverteringsgrader än statiska bilder.

En standardproduktbild lyfts till samma sofistikerade nivå som en premiumreklamfilm – med linsrotationer, dramatisk belysning och flytande rörelser – en traditionell produktion som kan kosta hundratals till tusentals pund.

Exempel på uppmaning:

The camera slowly orbits 90 degrees around the product, revealing

its form from multiple angles. Soft directional studio lighting

with subtle caustic reflections on the surface. A gentle highlight

sweep moves across the product. Clean, premium commercial aesthetic.

Shallow depth of field. Ultra-smooth camera movement. 4K quality.3. Scenisk tidsfördröjning

Förvandla landskapsfotografi till stämningsfulla time-lapse-videor. Moln sveper över himlen, vatten rinner, ljuset skiftar från gyllene till blått och löv svajar i vinden. Perfekt för reseinnehåll, flygbilder av fastigheter och stämningsfulla B-roll-klipp.

Landskapsfotografer och resevloggare på Bilibili kan direkt omvandla sina utvalda fotografier till fängslande time-lapse-videor, vilket avsevärt minskar produktionskostnaderna.

Ett landskapsfoto omvandlat till filmisk time-lapse – flytande moln, krusande vatten och skiftande ljus och skuggor – som skapar en dynamisk, stämningsfull kvalitet från en enda statisk bild.

Exempel på uppmaning:

Time-lapse effect. Clouds move steadily across the sky from left

to right. Water in the foreground ripples and flows gently. Light

shifts subtly as if the sun is moving, creating slowly changing

shadows on the landscape. Trees and grass sway gently in the wind.

Camera remains static on a tripod. Serene, majestic atmosphere.

Cinematic landscape quality.4. Innehåll på sociala medier

Omvandla dina mest populära statiska inlägg till videoinnehåll som får människor att stanna upp när de scrollar. Algoritmerna på plattformar som TikTok, Xiaohongshu, Bilibili och Kuaishou gynnar alla videoinnehåll – ett populärt bildinlägg får nästan garanterat bättre trafik när det omvandlas till en video.

För innehållsskapare på Xiaohongshu kan en uppsättning bild- och textinlägg få 3–5 gånger större exponering om de åtföljs av en videoversion. Douyin och Kuaishou använder dock enbart video som sitt huvudsakliga innehållsformat.

Exempel på uppmaning:

Dynamic, attention-grabbing motion. The subject moves confidently

toward the camera with energy and presence. Background elements

shift with parallax depth effect. Quick, punchy camera push-in

that creates impact. Vibrant colors, high contrast. Bold,

eye-catching aesthetic optimized for social media. Vertical 9:16.- Konst och illustration Animation

Ge liv åt konstverk, illustrationer, digitala målningar och grafisk design. Detta användningsområde är mycket populärt bland konstnärer, speldesigners och kreativa team som vill visa upp sina verk på ett mer engagerande sätt.

Inom Bilibili och Xiaohongshus konst- och anime-communityer rankas animerade illustrationer som mycket engagerande innehåll. Att omvandla statiska konstverk till videor i stil med "levande tapeter" ger ofta betydligt fler delningar och sparade bilder än originalbilderna.

Exempel på uppmaning:

The illustrated scene comes to life with gentle, painterly motion.

Characters move subtly within their positions -- breathing, shifting

weight, small gestures. Background elements like leaves, clouds,

or particles drift slowly. The artistic style is preserved exactly

as painted. Movement is smooth and dreamlike, like a living painting.

Gentle ambient lighting shifts. Fantasy illustration quality.6. Virtuella visningar av fastigheter

Omvandla fastighetsfotografier till virtuella visningsvideor. Fastighetsmäklare kan skapa uppslukande förhandsvisningar med hjälp av befintliga fastighetsbilder, vilket eliminerar behovet av att anlita specialiserade fotografer för fotografering på plats.

För fastighetsannonser som visas på plattformar som Ke.com och Anjuke, samt fastighetsreklam i sociala medier och på Xiaohongshu, visar dynamiska visningsvideor en betydligt högre konverteringsgrad för kundförfrågningar.

Exempel på uppmaning:

Smooth virtual walkthrough. The camera glides forward slowly into

the room, revealing the space with a wide-angle perspective.

Natural daylight streams through the windows, casting soft shadows.

Subtle dust particles float in the sunbeams. The camera pans

gently to the left, showing the full room layout. Clean, bright,

aspirational real estate aesthetic. Steady, professional movement.- Mode- och stylingshow

Skapa dynamiskt modeinnehåll från studiofotografier av kläder. Modellerna rör sig, tygerna faller naturligt, samtidigt som den estetiska stilen på redaktörsnivå förblir intakt.

Xiaohongshu-modebloggare och Taobao-klädförsäljare kan omvandla stora mängder befintliga modellbilder och flat-lay-bilder på kläder till dynamiska visningsvideor, vilket skapar större visuell effekt i informationsflödena.

Exempel på uppmaning:

The model strikes a confident pose and then slowly shifts their

weight, creating natural body movement. Fabric of the outfit

flows and catches the light with each subtle motion. Wind effect

gently moves the hair. Camera starts at full body and slowly drifts

upward to a waist-up shot. High-fashion editorial lighting with

strong directional shadows. Vogue magazine aesthetic. Cinematic

slow motion.- Utbildnings- och förklarande innehåll

Förvandla statiska diagram, infografik och pedagogiska illustrationer till dynamiska presentationer. Komplexa begrepp blir lättare att förstå när de sätts i rörelse.

Skapare på Bilibilis Knowledge Zone och olika utbildningsplattformar kan omvandla kursmaterial, diagram och flödesscheman till animerade videoklipp, vilket avsevärt förbättrar undervisningseffektiviteten och tittarnas kvarhållningsgrad.

Exempel på uppmaning:

The diagram elements animate sequentially. Arrows begin to flow

in their indicated directions. Labels fade in one by one. Moving

parts of the system activate in logical order, showing the process

step by step. Smooth transitions between stages. Clean, clear

educational style. Elements highlight with subtle glow as they

become active. Professional presentation quality.En omfattande guide till snabba tekniker för Tusheng Video

En välformulerad prompt är den mest effektiva metoden för att generera bilder från foton. Eftersom AI-systemet redan har sett din bild bör din prompt fokusera helt på rörelse och dynamik. Här är några tekniker som ger bäst resultat.

Snabbguide till nyckelord inom sport

Använd dessa specifika nyckelord för att kontrollera videorörelser med precision.

| Rörelsetyp | Nyckelord | Effekt | |-------- -|-------|------| | Kamera: Framåt | dolly in, push in, flytta närmare, närma sig | Kameran rör sig mot motivet | | Kamera: Bakåt | dolly out, dra tillbaka, backa, vidga | Kameran rör sig bort från motivet | | Tagning: Vänster/höger | panorera åt vänster, panorera åt höger, följa åt vänster, följa åt höger | Kameran roterar eller följer horisontellt | | Tagning: Upp/ner | luta uppåt, luta nedåt, kran uppåt, kran nedåt | Kameran roterar eller rör sig vertikalt | | Tagning: Orbit | orbit, rotera, rotera runt, båge | Kameran cirklar motivet | | Kamera: Zoom | zooma in, zooma ut, ändra brännvidd | Kameran zoomar (utan förflyttning) | | Motiv: Mikro-rörelser | andas, blinka, flytta tyngden, mikro-rörelser | Subtila, naturtrogna rörelser | | Motiv: Måttligt | vända huvudet, le, gestikulera, gå långsamt | Tydliga men kontrollerade rörelser | | Motiv: Dynamiskt | springa, hoppa, dansa, snurra, vinka | Energiska rörelser med hela kroppen | | Miljö: Mild | bris, drivande, svajande, krusande, skimrande | Mjuka rörelser i omgivningen | | Miljö: Intensiv | blåsa, rusa, krascha, virvla, kaskad | Kraftfulla rörelser i omgivningen | | Parallax | parallax, djupförskjutning, lager rör sig | Förgrund/bakgrund rör sig i olika hastigheter |

Olika nyckelord för kamerarörelser ger helt olika effekter. Välj din kamerarörelsesteknik medvetet utifrån det önskade resultatet.

Hastighets- och tempokontroll

Rörelsens tempo har en stor inverkan på den emotionella tonen i en video. Använd följande modifierare:

- Extremt långsamt: "knappt märkbart", "ultra-slow motion", "glacial takt" — Dramatiskt, kontemplativt

- Långsamt: "långsamt", "försiktigt", "gradvis", "lugnt" — elegans, filmisk kvalitet

- Medelhög: "stadigt", "naturligt tempo", "i gånghastighet" — realism, dokumentärstil

- Snabb: " snabbt", "raskt", "energiskt", "snabbt" – dynamiskt, upprymt

- Extremt snabbt: "snabbt", "whip pan", "snabb klippning", "rörelseutbrott" – spänt, actionfyllt

Avancerad teknik: Använd slow motion som standard. I AI-genererade videor ser slow motion nästan alltid bättre ut än snabb rörelse. Snabba rörelser ökar risken för brister och visuella inkonsekvenser.

Oberoende rörelsekontroll av bakgrund och motiv

Du kan självständigt styra vad som rör sig och vad som förblir stilla. Detta är en kraftfull teknik för att styra publikens uppmärksamhet.

Motivet i rörelse, bakgrunden stilla:

The person walks forward confidently while the background remains

perfectly still. Static camera, no camera movement. Focus entirely

on the subject's motion.Dynamisk bakgrund, statiskt motiv:

The person stands completely still, like a statue. Behind them,

clouds drift across the sky, leaves blow in the wind, and city

lights flicker. Only the environment moves.Separata rörelser från båda sidor:

The person slowly turns their head while the camera simultaneously

dollies in. Background clouds drift in the opposite direction,

creating a sense of depth and dimension.Skillnaden mellan kamerarörelse och objektrörelse

Att förstå skillnaden mellan kamerarörelser och objektrörelser är avgörande för att uppnå önskad effekt.

Kamerarörelser förändrar perspektiv och komposition. Scenen i sig förblir oförändrad, medan synvinkeln förändras. Används för att: avslöja scenen, etablera miljön och skapa dramatisk effekt.

Objektrörelse avser rörelsen av element inom en scen medan kameran förblir stillastående. Den används för: karaktärsanimation, produktdemonstrationer och naturlig miljödynamik.

Kombinerade rörelser använder båda samtidigt. Detta är den mest filmiska tekniken, men också den mest utmanande för AI att utföra väl. Det är lämpligt att först behärska en enda typ av rörelse och först lägga till den andra när du är nöjd.

Avancerade promptstrukturer

För att uppnå mest förutsägbara resultat, ordna dina frågor i följande ordning:

- Primär handling — Vad huvudpersonen gör

- Kamerarörelse — Hur kameran rör sig

- Miljödynamik — Vad miljöelementen gör

- Hastighet/Tempo — Tempot för alla rörelser

- Atmosfär/stämning — Emotionell ton

- Förbättring av visuell kvalitet — Teknisk beskrivning av visuell kvalitet

Exempel på användning av denna struktur:

[Subject] A young woman in a flowing white dress slowly raises

her hand to brush hair from her face.

[Camera] The camera executes a slow, steady dolly in from a

medium shot to a close-up.

[Environment] Cherry blossom petals drift gently through the

air. Soft golden sunlight filters through the trees.

[Speed] All motion is slow and deliberate, almost dreamlike.

[Mood] Romantic, ethereal, peaceful atmosphere.

[Quality] Cinematic shallow depth of field, anamorphic bokeh,

film grain, 4K quality.2026 TuSheng Video AI-verktyg Jämförelse

Konkurrensen inom videostreamingsektorn hårdnar. Nedan följer en jämförande analys av de vanligaste plattformarna i februari 2026, med särskilt fokus på tillgänglighet för användare i Kina.

Bearbetningseffekterna av samma källbild på fem olika plattformar för videogenerering. Skillnaderna i rörelsekvalitet, tidsmässig konsistens och visuell trohet är omedelbart uppenbara.

| Funktion | Seedance 2.0 | Runway Gen-4 | Pika 2.0 | Kling 3.0 | Luma Dream Machine | |------|-------------|-------------|---------|------ ----------|-------------------| | Maximal upplösning | 2K (2048x1080) | 4K (uppskalad) | 1080p | 1080p | 1080p | | Maximal längd | 15 sekunder | 10 sekunder | 5 sekunder | 2 minuter | 5 sekunder | | Inmatningsalternativ | Bild + text + video + ljud | Bild + text + video | Bild + text | Bild + text | Bild + text | | Inmatning av flera bilder | Stöds (upp till 9 bilder) | Stöds inte | Stöds inte | Stöds inte | Stöds inte | | Inbyggt ljud | Stöds (8 språk med läppsynkronisering) | Stöds inte | Delvis (ljudeffekter) | Stöds inte | Stöds inte | | Kamerakontroll | Promptbaserad | Rörelsepensel + regissörsläge | Grundläggande | Grundläggande | Promptbaserad | | Gratis kvot | Tillgänglig (Registreringsbonus) | Tillgänglig (begränsad) | Tillgänglig (begränsad) | Tillgänglig (begränsad) | Tillgänglig (begränsad) | | Startpris | ~9,90 $/månad | 15 $/månad | 10 $/månad | ~6,99 $/månad | 9,99 $/månad | | Tillgång från Kina | Direkt tillgänglig | VPN krävs | VPN krävs | Direkt tillgänglig | VPN krävs | | Bäst lämpad för | Multimodal kontroll, bildkvalitet | Professionellt redigeringsflöde | Nybörjare, roliga effekter | Långa videor, högt värde | Filmisk känsla, 3D-scener |

Detaljerade recensioner av varje verktyg

Seedance 2.0 är oöverträffad när det gäller flexibilitet för inmatning. Det är den enda plattformen som stöder samtidig uppladdning av upp till nio referensbilder, ljudinmatning med läppsynkronisering och kombination av alla inmatningslägen inom en enda generation. För maximal kontroll över bild-till-video-utmatningen erbjuder Seedance den mest omfattande verktygslådan. Dess 2K-upplösning är också den högsta bland alla verktyg (utan att förlita sig på uppsampling). Utvecklad av ByteDance (moderbolag till TikTok), kan användare i Kina komma åt den direkt utan att behöva VPN eller utländska betalningsmetoder.

Runway Gen-4 utmärker sig genom sin precisa kontroll. Med Motion Brush kan du noggrant "måla" vilka delar av en bild som ska röra sig och i vilken riktning. Om du behöver kirurgisk precision över specifika områden är Runway det bästa valet. Nackdelarna är det högre priset och lägre genereringskvoter. För att få tillgång till tjänsten i Kina krävs en VPN.

Pika 2.0 är det mest tillgängliga alternativet. För nybörjare som vill experimentera med att skapa bilder till video utan att lära sig prompt engineering, erbjuder Pikas effekter med ett klick och strömlinjeformade gränssnitt den lägsta inträdesbarriären. Även om bildkvaliteten inte når upp till premiumverktyg, är den fullt tillräcklig för vardagligt socialt innehåll. Kräver VPN för åtkomst inom Kina.

Kling 3.0 överträffar sina konkurrenter både när det gäller körtid och prisvärdhet. Om du behöver skapa längre videor – 30 sekunder, 1 minut eller till och med 2 minuter – från en enda bild, är Kling det enda rimliga alternativet. Pris-bildkvalitetsförhållandet är exceptionellt fördelaktigt. Begränsningen ligger i de begränsade inmatningsalternativen (enkel bild + text). Som en produkt under Kuaishou är Kling direkt tillgängligt inom Kina, vilket gör det till ett annat smidigt alternativ för inhemska användare.

Luma Dream Machine utmärker sig inom rumslig förståelse. För landskap, arkitektur och scener där tredimensionell rumslig medvetenhet är avgörande, producerar Luma de mest övertygande parallax- och kamerarörelserna. Karaktärsanimeringarna är dock sämre än konkurrenternas. För att få tillgång i hemlandet krävs ett VPN.

Rekommendationer för användare i Kina

Om du befinner dig i Kina finns det i huvudsak två videoverktyg som kan användas direkt utan VPN:

- Seedance 2.0 — Utvecklad av ByteDance, fullt funktionell och redo att användas, med multimodal inmatning + 2K-upplösning + integrerat ljud

- Kling 3.0 — En produkt under Kuaishou, utmärker sig i generering av långa videor med enastående valuta för pengarna

Även om utländska verktyg som Runway, Pika och Luma har sina egna unika funktioner, kräver de alla VPN-åtkomst och utländska betalningsmetoder, vilket innebär en högre inträdesbarriär.

För innehållsskapare på inhemska plattformar som Douyin, Xiaohongshu, Bilibili och Kuaishou innebär valet av verktyg som är direkt tillgängliga i Kina inte bara större bekvämlighet utan också mer tillförlitlig nätverksstabilitet och enklare betalningar.

För en mer omfattande jämförelse (inklusive text-till-video-funktioner), se vår Kompletta ranking av AI-videogeneratorer för 2026.

Vanliga fel och korrigeringsmetoder

Efter att ha testat tusentals videoklipp har vi här listat de fem vanligaste felen vi observerat – tillsammans med specifika åtgärder för att rätta till dem.

- Använd stockbilder med låg upplösning

Felet som begicks: Att ladda upp en liten, komprimerad bild (till exempel en miniatyrbild på 400x300 som sparats från WeChat eller sociala medier) och samtidigt förvänta sig att få en högupplöst video.

Varför det misslyckas: Kodaren kan inte extrahera tillräcklig visuell information från bilder med låg upplösning. Utgången ärvde suddigheten samtidigt som rörelseartefakter överlagrades.

Så här åtgärdar du problemet: Använd alltid bilden med högsta upplösning. Om endast bilder med låg upplösning finns tillgängliga, använd ett AI-uppskalningsverktyg (t.ex. Real-ESRGAN eller Topaz Gigapixel) för att förbättra upplösningen innan du laddar upp bilden. Den minsta rekommenderade storleken är 1024x1024 pixlar.

- Skriv scenbeskrivningar istället för handlingsbeskrivningar

Det misstag som gjordes: Skrivuppslag som "Havets yta vid solnedgången, med gyllene ljus som glittrar på vattnet." Detta beskriver bildens utseende – något som AI redan vet.

Varför det misslyckades: AI:n har redan kodat bilden. Att beskriva bildens innehåll för den slösar bort utrymme för överflödig information och ger ingen riktning för rörelse.

Hur man reviderar: Fokusera beskrivningen helt på rörelsen. Skriv om till: "Vågor rullar mjukt mot stranden. Gyllene solljus glittrar på vattenytan. Molnen driver långsamt från vänster till höger. Kameran panorerar långsamt åt höger och följer kustlinjen."

- Att kräva att för många åtgärder ska utföras samtidigt

Misstag som gjorts: "Karaktären vänder sig om, vinkar, går framåt, tar upp en kopp, ler och dansar, medan kameran zoomar in, panorerar åt vänster och lutar."

Varför det misslyckas: Nuvarande AI-modeller kan inte på ett tillförlitligt sätt koordinera mer än två eller tre samtidiga åtgärder. Överbelastade kommandon gör att modellen antingen ignorerar de flesta instruktioner eller producerar förvirrade, felaktiga resultat.

Hur man redigerar: Begränsa varje generation till en primär handling plus en kamerarörelse. För komplexa kontinuerliga handlingar, skapa flera korta klipp separat innan du redigerar och sammanfogar dem.

- Ignorera felaktiga bildförhållanden

Felet som begicks: Ladda upp en bild i liggande format 16:9 men ställa in utskriften till stående format 9:16, eller vice versa.

Varför det misslyckas: AI beskär antingen bilden drastiskt eller kräver att stora tomma områden fylls i. Inget av dessa tillvägagångssätt ger tillfredsställande resultat – beskärning komprometterar den noggrant komponerade inramningen, medan fyllning av stora nya områden leder till inkonsekvenser.

Så här åtgärdar du problemet: Se till att utgångsbildens bildförhållande stämmer överens med källbildens proportioner. Använd 16:9 för liggande bilder och 9:16 för stående bilder. Om ett annat bildförhållande krävs, beskär källbilden till önskade proportioner innan du laddar upp den.

- Förvänta sig en fotorealistisk effekt från en illustration

Det misstag som gjordes: Att ladda upp en tecknad illustration eller en platt designbild och förvänta sig att AI skulle generera fotorealistisk videorörelse.

Varför det misslyckas: Modellen försöker tolka konstnärliga stilar, vilket ibland leder till oönskad realism. Platta illustrationer saknar det djup och de ljussignaler som modellen är beroende av för att kunna förutsäga naturliga rörelser.

Så här åtgärdar du problemet: Om källmaterialet är en illustration, ange tydligt stilen i prompten: ”Behåll den illustrerade konststilen exakt. Animerad i en 2D-animationsstil, inte fotorealistisk. Rörelserna ska kännas handritade och måleriska.” Detta instruerar modellen att bevara den konstnärliga stilen istället för att införa fotorealism.

Vanliga frågor

Vilket AI-verktyg är bäst lämpat för att skapa videor från bilder?

Seedance 2.0 är vårt bästa rekommendation för bild-till-video-generering år 2026. Det stöder flera bildinmatningar (upp till 9 referensbilder), utmatar i 2K-upplösning och erbjuder den mest flexibla kombinationen av bilder, text, video och ljud. Dessutom, utvecklat av ByteDance, är Seedance direkt tillgängligt inom Kina. För budgetmedvetna användare erbjuder Kling 3.0 enastående bildkvalitet till ett lägre pris och är också direkt tillgängligt i Kina. För nybörjare har Pika 2.0 det enklaste gränssnittet. Det optimala valet beror på dina specifika krav – se vår [verktygsjämförelsetabell](#2026-year image-to-video AI tool comparison).

Kan TuSheng Video användas gratis?

Självklart. Flera plattformar erbjuder kostnadsfria kvoter. Seedance ger gratis krediter till alla nya användare – inget kreditkort krävs. Pika 2.0 och Luma Dream Machine erbjuder också begränsad kostnadsfri generering. HaiLuo AI ger 10 kostnadsfria genereringar per dag. Dessa kostnadsfria kvoter räcker för att testa tekniken och producera flera videor. För kontinuerlig användning är betalda abonnemang mer kostnadseffektiva. För ytterligare strategier för gratis användning, se vår Seedance Free Usage Guide.

Vad är den maximala längden för AI-genererade videor?

Olika plattformar har olika begränsningar. Kling 3.0 är ledande inom området och genererar videor på upp till 2 minuter per bild. Seedance 2.0 har en gräns på 15 sekunder. Runway Gen-4 har en gräns på 10 sekunder. Pika 2.0 och Luma Dream Machine begränsar videor till 5 sekunder. För de flesta sociala medier och marknadsföringsscenarier är 5–15 sekunder den optimala längden. Om längre filmmaterial krävs kan man skapa flera korta klipp för efterföljande redigering och sammanfogning, eller använda Kling för att skapa långa videor från en enda tagning.

Vilket bildformat är mest lämpligt för AI-videogenerering?

PNG är optimalt eftersom det är ett förlustfritt format utan komprimeringsartefakter. WebP (förlustfritt läge) ger likvärdiga resultat med mindre filstorlekar. JPG är också lämpligt i de flesta fall, men kraftigt komprimerade JPG-filer med märkbara komprimeringsartefakter försämrar utskriftskvaliteten. Undvik att använda GIF, BMP eller andra icke-standardformat. Alla större plattformar stöder JPG, PNG och WebP. Minsta upplösning: 512x512 pixlar. Rekommenderat: 1024x1024 eller högre.

Kan AI animera alla typer av bilder?

AI kan animera de flesta bildtyper, men resultaten varierar beroende på motivet. Porträtt och huvudbilder ger de bästa resultaten – nuvarande modeller tolkar naturliga ansiktsrörelser och hårrörelser korrekt. Landskap och naturliga scener fungerar också exceptionellt bra, med övertygande skildringar av molnrörelser, strömmande vatten och vajande vegetation. Produktbilder med ren bakgrund ger genomgående tillförlitliga resultat. Illustrationer och konstverk kan animeras, men skräddarsydda stilistiska instruktioner kan krävas för att undvika oönskad fotorealism. Komplexa gruppscener, bilder som innehåller mycket text och fotografier av låg kvalitet ger de minst stabila resultaten.

Vad är skillnaden mellan bildgenererad video och textgenererad video?

Text-till-video genererar både visuellt innehåll och rörelse samtidigt från textbeskrivningar. AI styr hela det visuella utseendet, vilket ger mindre kontroll över specifika detaljer men större kreativ frihet. Bild-till-video använder dina befintliga bilder som utgångspunkt och genererar endast rörelsen. Du behåller precis kontroll över det visuella resultatet, eftersom du tillhandahåller den visuella referensen. Bild-till-video är vanligtvis mer förutsägbart och konsekvent i resultatet, eftersom AI har en konkret visuell förankring. Text-till-video är bättre lämpat för att låta AI skapa helt nytt innehåll från grunden.

Kan Tusheng Video styra kamerans rörelser?

Absolut. De flesta moderna generativa videoverktyg stöder styrning av kamerarörelser via textkommandon. Du kan ange rörelser som "dolly in", "pan left", "orbit around", "crane up", "zoom out" och "tracking shot". Seedance 2.0 och Luma Dream Machine reagerar särskilt exakt på dessa rörelsesnyckelord. Runway Gen-4 erbjuder ytterligare precision genom sina funktioner Motion Brush och Director Mode, som möjliggör visuell ritning av kamerans rörelsebana. Det är lämpligt att endast ange en rörelsetyp per generation, kompletterat med hastighetsmodifierare som "slowly" (långsamt) eller "steadily" (stadigt).

Är bildkvaliteten på AI-genererade videor tillräcklig för professionella tillämpningar?

För korta videoklipp (5–15 sekunder) är det fullt möjligt. Resultat från förstklassiga plattformar som Seedance 2.0 och Runway Gen-4 har redan använts professionellt för marknadsföring på sociala medier, produktvideor för e-handel, fastighetspresentationer och reklamkoncept. Inom landet innehåller betydande kommersiellt innehåll på Douyin och Xiaohongshu nu AI-genererade videotillgångar. Det finns dock fortfarande begränsningar: längre speltider ökar risken för brister, komplexa scener med flera motiv är fortfarande instabila och textåtergivningen i videor är ännu inte felfri. För sändningar av sändningskvalitet eller filmverk som kräver absolut perfektion är traditionell filmning fortfarande det säkrare alternativet. För digital marknadsföring och socialt innehåll har AI-tekniken för bild-till-video nu nått professionell standard.

Sammanfattning

TuSheng Video AI har utvecklats från en nyhet till ett viktigt verktyg för innehållsskapande. Tekniken har mognat, verktygen har blivit användarvänliga och kvaliteten på resultatet uppfyller nu professionella standarder för de allra flesta scenarier inom digitalt innehåll.

Följande är de viktigaste punkterna:

- Kvaliteten på källbilderna är avgörande. Skarpa, välkomponerade bilder med hög upplösning ger betydligt bättre resultat än suddiga bilder eller bilder med låg upplösning.

- Skriv rörelse, inte beskrivning. AI:n har redan sett din bild. Berätta hur saker ska röra sig, inte hur de ser ut.

- **Börja enkelt. ** En handling plus en kamerarörelse. Behärska grunderna innan du lägger till komplexitet.

- Iterera snabbt. Skapa korta testklipp först; producera den fullständiga versionen först när du är nöjd.

- **Anpassa verktygen efter uppgifterna. ** Seedance prioriterar visuell trohet och multimodal kontroll; KeLing utmärker sig i långa videor och kostnadseffektivitet; Runway fokuserar på precis redigering; Pika betonar enkelhet och användarvänlighet.

- Välj det verktyg som passar dina behov. Om du befinner dig i Kina kan Seedance och KeLing användas direkt utan ytterligare nätverks- eller betalningsbarriärer.

Klyftan mellan varumärken och kreatörer som använder Tusheng Video AI och deras kollegor som fortfarande förlitar sig på statiska bilder växer för varje månad. Varje fotografi i ditt produktbibliotek är en potentiell videoreklam. Varje porträtt är en potentiell animerad avatar. Varje landskap är potentiellt filmiskt B-roll-material.

Skapa din första bild-till-video gratis --> — Ladda upp valfri bild och se den komma till liv inom två minuter. Inget kreditkort krävs, direkt tillgängligt i Kina.

Vill du utforska fler AI-videofunktioner? Upplev Seedance på alla plattformar --> — Text-till-video, video-till-video, multimodal generering: allt hanteras på ett och samma ställe.

Ytterligare läsning: Seedance Complete User Guide | Seedance Prompt Guide med över 50 exempel | AI Video Creative Application Cases | De bästa AI-videogeneratorerna 2026 rankade | Guide till AI-videomarknadsföring och sociala medier*