Samenvatting

Image-to-Video AI maakt gebruik van deep learning-technologie op basis van diffusiemodellen om statische afbeeldingen om te zetten in dynamische video's. In tegenstelling tot het genereren van puur tekst-naar-video, hoeft u alleen maar een foto te uploaden zodat de AI realistische bewegingen, camerabewegingen en tijdelijk samenhangende beelden eromheen kan genereren, waardoor u meer controle hebt over het eindresultaat. Deze gids behandelt uitgebreid: de technische principes achter Image-to-Video AI; welke soorten afbeeldingen optimale resultaten opleveren; een praktische tutorial in vijf stappen om uw eerste video helemaal zelf te maken; acht praktische use cases met voorbeelden; geavanceerde technieken voor bewegingscontrole; en een vergelijking in de praktijk van gangbare tools in 2026 (inclusief tools die direct toegankelijk zijn in China). Probeer Image-to-Video AI gratis uit -->

TuSheng Video AI neemt je foto's en genereert levensechte bewegingen, filmische camerabewegingen en temporele continuïteit, waardoor een enkel frame wordt omgezet in een filmische videoclip.

Wat is Tusheng Video AI?

Image-to-Video AI is een kunstmatige intelligentietechnologie die video's kan genereren op basis van statische afbeeldingen. U levert een foto aan – of het nu een portret, productafbeelding, landschap of kunstwerk is – en het AI-model produceert een korte video waarin elementen beginnen te bewegen, camerahoeken verschuiven en de hele scène tot leven komt.

In essentie maken de meeste generatieve videosystemen gebruik van videodiffusiemodellen. Deze neurale netwerken worden getraind op basis van miljoenen paren van videobeelden en gegevens, waarbij ze de statistische relatie tussen statische frames en daaropvolgende natuurlijke bewegingen leren. Wanneer het model een nieuw beeld te zien krijgt, voorspelt het welke beweging het meest natuurlijk lijkt en genereert het een continue reeks frames die vloeiend overgaan vanuit de oorspronkelijke foto.

Verschillen met tekst-naar-video

Text-to-Video genereert content volledig op basis van tekst. De AI creëert tegelijkertijd zowel visuele content als beweging op basis van uw tekstuele prompt – krachtig maar onvoorspelbaar, aangezien de AI zelfstandig het uiterlijk van het onderwerp, de scènecompositie en alle bewegingspatronen bepaalt.

Tusheng Video draait deze logica om: jij zorgt voor het visuele anker. De AI weet al hoe de scène eruitziet, omdat je die rechtstreeks hebt laten zien. De enige taak van de AI is het genereren van plausibele bewegingen. Dit betekent:

- Meer controle: uw afbeeldingen bepalen het onderwerp, de compositie, het kleurenpalet en de stijl

- Minder giswerk: AI vereist geen interpretatie van vage tekstuele beschrijvingen

- Verbeterde consistentie: de output sluit nauw aan bij de bronafbeeldingen

- Snellere iteraties: Het aanpassen van de bewegingsprompt is veel eenvoudiger dan het herschrijven van de volledige scènebeschrijving

Waarom TuSheng Video zo belangrijk is in 2026

TuSheng Video AI is geëvolueerd van een experimenteel speeltje naar een productief hulpmiddel. E-commerce merken transformeren productafbeeldingen naar geanimeerde advertenties, contentmakers brengen hun populairste posts tot leven, makelaars maken virtuele bezichtigingsvideo's van foto's van onroerend goed en docenten animeren illustraties uit schoolboeken.

Deze technologie heeft een keerpunt bereikt: video's van 5 tot 15 seconden die zijn gegenereerd op basis van bronafbeeldingen van hoge kwaliteit zijn nu in de meeste scenario's vrijwel niet meer te onderscheiden van traditionele beelden. Dit is precies de reden waarom de conversie van afbeeldingen naar video de snelst groeiende categorie binnen AI-videogeneratie is geworden.

Deze trend is vooral duidelijk op de Chinese markt. Algoritmen op platforms zoals Douyin, Xiaohongshu, Bilibili en Kuaishou geven allemaal de voorkeur aan videocontent, waardoor er onder makers een ongekende vraag is ontstaan naar tools waarmee foto's snel kunnen worden omgezet in video's. Tusheng Video AI speelt precies in op deze leemte in de markt.

Technische principes van Tusheng Video AI

Als je het technische proces begrijpt, kun je betere resultaten behalen. Als je weet waarom AI zich op een bepaalde manier gedraagt, kun je betere input geven en effectievere prompts schrijven. Hier volgt het vierstappenproces dat zich achter de schermen afspeelt.

De vier fasen van de AI-verwerkingspijplijn van Tusheng Video: beeldcodering, bewegingsvoorspelling, framegeneratie en temporele afvlakking.

Stap één: Beeldcodering

De AI analyseert eerst uw invoerafbeelding via een encodernetwerk en comprimeert deze tot een compacte wiskundige weergave die bekend staat als een latente vector. Dit kan worden gezien als het extraheren van een 'vingerafdruk' van uw afbeelding door de AI, waarbij de structuur, kleur, diepte, positie van het onderwerp, belichtingsrichting en semantische informatie worden vastgelegd.

Deze latente weergave is aanzienlijk compacter dan de oorspronkelijke pixelgegevens, waardoor verdere berekeningen haalbaar worden. De kwaliteit van de codering heeft een directe invloed op de uitvoerresultaten. Inputbeelden met een hogere resolutie en scherpte genereren rijkere latente weergaven, wat uiteindelijk resulteert in een superieure video-uitvoer.

Stap twee: Bewegingsvoorspelling

Dit is de creatieve kern van het hele proces. Het diffusiemodel voorspelt wat voor soort beweging er natuurlijk uitziet op basis van je originele afbeelding, waarbij rekening wordt gehouden met:

- Scenische context: Een foto van de oceaan impliceert dat er golven moeten zijn; een portret suggereert subtiele gezichtsuitdrukkingen

- Diepte-informatie: Objecten dicht bij de lens kunnen andere bewegingspatronen vertonen dan objecten in de verte

- Fysiek realisme: Haar moet met de wind mee wapperen, water moet naar beneden stromen en stof moet op natuurlijke wijze vallen

- Uw tekstprompt: Als u "langzaam naar links pannen" opgeeft, past het model zijn bewegingsvoorspelling hierop aan.

Het model vervormt niet alleen pixels. Het genereert volledig nieuwe visuele content voor gebieden die nieuw zichtbaar worden door camerabewegingen of objectbewegingen. Als de camera naar rechts draait, vult het model het gebied buiten de rechterrand van het oorspronkelijke beeld 'op'.

Stap drie: Frame genereren

Op basis van bewegingsvoorspelling genereert het model een reeks videoframes. Elk frame wordt geproduceerd via een omgekeerd diffusieproces: het begint met ruis en wordt geleidelijk verfijnd tot een duidelijk beeld, terwijl de consistentie met het voorgaande frame en het oorspronkelijke beeld behouden blijft.

Seedance 2.0 en andere moderne modellen genereren hoge framesnelheden (24–30 fps) met behoud van subpixelconsistentie tussen frames. Dit zorgt voor een vloeiende, flikkervrije uitvoer zonder de judderproblemen die bij eerdere systemen vaak voorkwamen.

Stap vier: Tijdsgladheid

De laatste stap zorgt voor vloeiende overgangen tussen alle gegenereerde frames. Het temporele aandachtsmechanisme controleert of de helderheid, kleur en beweging gedurende de hele video consistent blijven, waardoor veelvoorkomende visuele artefacten worden voorkomen:

- Plotselinge kleurverschuivingen tussen frames

- Onverwacht verschijnen of verdwijnen van objecten

- Onnatuurlijke versnelling of vertraging van bewegingen

- Flikkering van oppervlaktetextuur

Het eindresultaat is een prachtige video die op natuurlijke wijze voortvloeit uit het originele beeldmateriaal.

Waarom zien sommige afbeeldingen er beter uit?

Nu begrijpt u waarom de kwaliteit van de invoerafbeelding zo cruciaal is. Een wazige afbeelding met een lage resolutie leidt in de eerste stap tot een ruisachtige codering, waardoor het bewegingsvoorspellingsmodel (de tweede stap) minder informatie krijgt. Dit resulteert in minder nauwkeurige bewegingen en meer visuele artefacten in de uiteindelijke uitvoer. Omgekeerd levert een scherpe, goed samengestelde afbeelding met duidelijke diepte-indicaties het model rijke informatie op, wat zich vertaalt in een natuurlijkere video van hogere kwaliteit.

Wat voor soort afbeelding levert de beste resultaten op?

Niet alle beelden zijn geschikt voor TuSheng Video AI. Het verschil tussen goed bronmateriaal en slecht bronmateriaal kan wel eens het verschil zijn tussen een verbluffende video en een stapel onbruikbaar beeldmateriaal. Hier volgt een praktische handleiding.

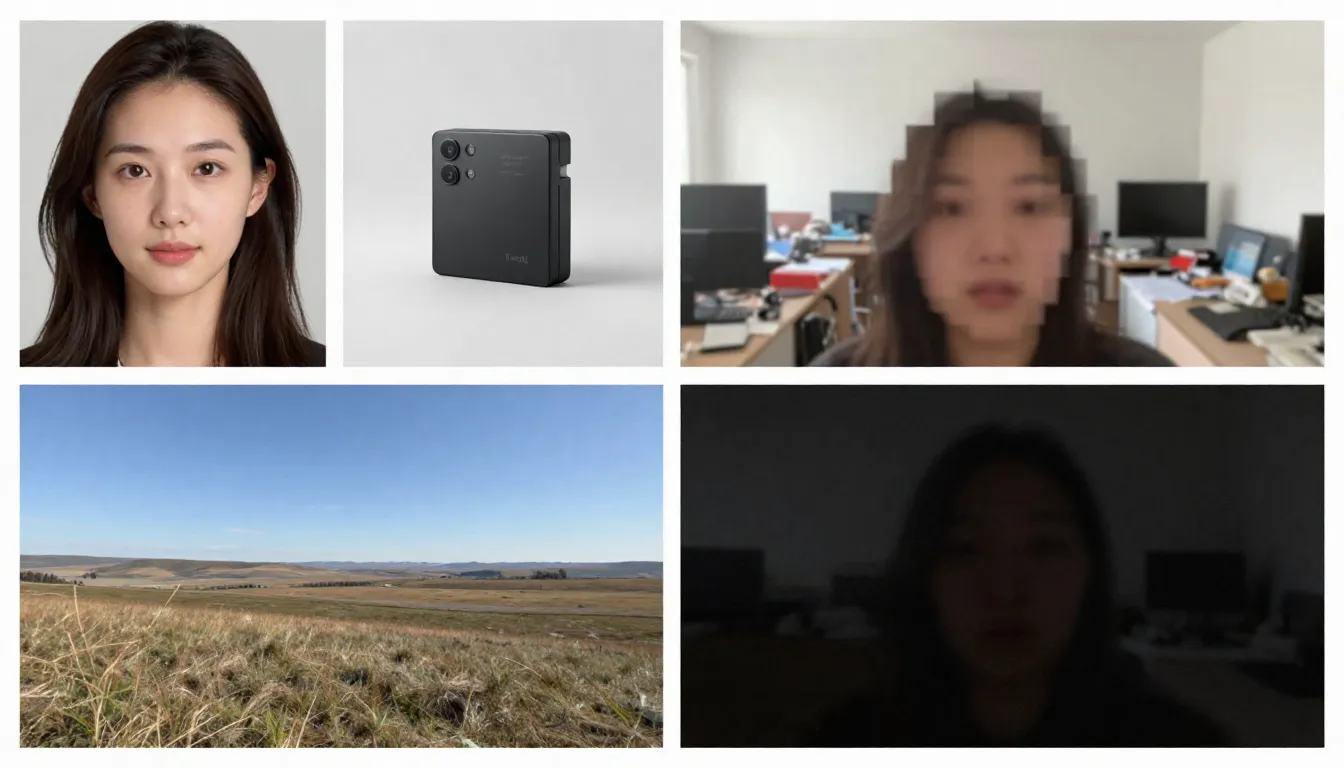

Aan de linkerkant worden geschikte bronafbeeldingen weergegeven (hoge resolutie, goed samengesteld, natuurlijke bewegingen suggererend), terwijl aan de rechterkant ongeschikte bronafbeeldingen worden getoond (wazig, rommelig, elementen bevatten die moeilijk te verwerken zijn voor AI).

Geschikte afbeeldingstypen

Hoge resolutie (1024x1024 of hoger). Meer pixels zorgen ervoor dat de encoder meer details kan extraheren. Gebruik altijd de versie met de hoogste resolutie die beschikbaar is. Minimaal aanbevolen: 512x512 pixels. Ideaal: 1024x1024 of hoger.

Onderwerpen zijn duidelijk gedefinieerd met duidelijke contouren. De AI moet onderscheiden wat moet bewegen en wat statisch moet blijven. Een portret waarbij het onderwerp scherp is afgescheiden van de achtergrond levert veel betere resultaten op dan een complexe, chaotische groepsscène.

Goed belicht en correct geëxposeerd. Afbeeldingen met goede belichting geven nauwkeurige kleur- en diepte-informatie voor het model. Vermijd afbeeldingen die sterk overbelicht of onderbelicht zijn.

Natuurlijke gelaagdheid en compositie. Beelden met een duidelijk onderscheid tussen voorgrond, middengrond en achtergrond geven AI diepte-informatie, waardoor het realisme van parallax-effecten en camerabewegingen wordt verbeterd.

Beelden die beweging suggereren. Afbeeldingen die beweging suggereren – haar dat door de wind wordt bewogen, golven die op het punt staan om op het strand te breken, een persoon die een stap zet – bieden het model een krachtig uitgangspunt voor het voorspellen van beweging. AI kan aan de hand van deze visuele aanwijzingen begrijpen "wat er vervolgens gebeurt".

Strakke achtergronden. Een eenvoudige of natuurlijk wazige achtergrond zorgt voor een vloeiendere video-uitvoer dan een rommelige achtergrond vol met kleine objecten.

Afbeeldingstypen die problemen kunnen veroorzaken

Wazige of onscherpe beelden. Wazige invoer, wazige uitvoer. AI kan geen scherpte toevoegen die niet in het originele beeld aanwezig was.

Overdreven complexe scènes. Beelden met veel kleine onderwerpen, ingewikkelde patronen of visuele rommel kunnen bewegingsvoorspellingsmodellen overbelasten, waardoor ze niet meer kunnen bepalen wat er moet bewegen en hoe.

Uitgebreide tekst of typografie. AI-videomodellen hebben nog steeds moeite om de leesbaarheid van tekst in alle frames te behouden. Als uw afbeeldingen logo's, merknamen of tekstoverlays bevatten, zal er vervorming optreden in de video-uitvoer.

Lage resolutie (512x512 of lager). Kleine afbeeldingen bevatten onvoldoende informatie. Zelfs het vergroten ervan met AI vóór invoer blijkt zinloos: het voegt pixels toe, maar geen informatie.

Zware filters of nabewerking. Extreme kleuraanpassingen, HDR-bewerking of uitgebreide Photoshop-wijzigingen kunnen het begrip van het model van belichting en diepte verstoren.

Meerdere gezichten van verschillende grootte. AI verwerkt individuele portretten effectief. Groepsfoto's met gezichten op verschillende afstanden leveren inconsistente animaties op: sommige gezichten zien er natuurlijk uit, terwijl andere vervormd raken.

Checklist voor zelfcontrole vóór het uploaden

Controleer voordat u afbeeldingen uploadt snel de volgende punten:

- Minimale resolutie van 1024x1024 pixels

- Onderwerp duidelijk gedefinieerd met duidelijke scheiding van de achtergrond

- Correcte belichting (niet onderbelicht of overbelicht)

- Geen zware filters, extreme HDR of zichtbare kunstmatige bewerking

- Minimaal tekst, logo's of typografische elementen

- Beperkte complexiteit van de scène (1–3 primaire onderwerpen)

- Afbeeldingsformaat: JPG, PNG of WebP

Zodra aan deze voorwaarden is voldaan, kan de opwekking beginnen.

Stapsgewijze handleiding: maak je eerste afbeelding-naar-video

Volg deze vijf stappen om elke statische afbeelding om te zetten in een geanimeerde AI-video. We gebruiken Seedance als demonstratieplatform, maar deze principes zijn van toepassing op elke tool voor het omzetten van afbeeldingen naar video.

Stap één: geschikte bronafbeeldingen selecteren

De bronafbeelding is de belangrijkste factor die de uitvoerkwaliteit bepaalt. Selecteer een afbeelding die voldoet aan de eerder beschreven richtlijnen. Voor uw eerste poging raden we u aan een eenvoudig portret of een landschap met uitgesproken diepte te kiezen. Deze twee soorten afbeeldingen leveren de meest consistente resultaten op.

Aanbevolen afbeeldingen voor eerste pogingen:

- Duidelijke portretfoto of halflang portret met goede belichting

- Landschappen met lucht, wateroppervlakken of vegetatie (deze elementen hebben inherente beweging)

- Productafbeeldingen tegen een effen achtergrond

- Kunstwerken of illustraties met duidelijk gedefinieerde elementen

Vermijd bij het voor het eerst genereren het gebruik van complexe collages, afbeeldingen met grote hoeveelheden tekst of sterk bewerkte foto's.

Stap twee: uploaden naar Seedance

Open Seedance Image-to-Video en upload de door u geselecteerde afbeeldingen. Seedance ondersteunt de formaten JPG, PNG en WebP. Het platform analyseert uw afbeeldingen automatisch en maakt ze klaar voor generatie.

Als een afbeelding uitzonderlijk groot is (met een zijde van meer dan 4096 pixels), zal het systeem deze automatisch schalen met behoud van de verhoudingen, waardoor handmatige aanpassing niet nodig is.

Stap drie: Een actiegerichte prompt opstellen

In dit stadium informeert u de AI over de gewenste beweging. Uw prompt moet de dynamiek beschrijven in plaats van de inhoud van de afbeelding (de AI heeft de afbeelding al gezien). Concentreer u op de volgende punten:

- Beweging van het onderwerp: Wat moet het onderwerp doen?

- Beweging van de camera: Hoe moet de camera bewegen?

- Beweging van de omgeving: Welke dynamiek moet er in de omgeving aanwezig zijn?

- Tempo en sfeer: Moet het algemene tempo snel of langzaam zijn?

Voorbeelden van portretprompts:

The woman slowly turns her head to the right and smiles softly.

A gentle breeze moves her hair. Background slightly out of focus

with subtle bokeh movement. Camera slowly pushes in from medium

shot to a close-up. Warm, natural lighting. Cinematic film quality.Voorbeeld van een landschapsopdracht:

Gentle waves roll toward the shore in slow motion. Clouds drift

slowly across the sky from left to right. Sunlight shimmers on

the water surface. Camera slowly pans right, revealing more of

the coastline. Peaceful, serene atmosphere. 4K cinematic quality.Voorbeeld van een productprompt:

The camera slowly orbits around the product, rotating 45 degrees

clockwise. Soft studio lighting with subtle caustic reflections

on the surface. Clean white background with gentle gradient.

Premium commercial aesthetic. Smooth, steady camera movement.Kernprincipe: Beschrijf de beweging, niet de scène. De scène bestaat al in je beeld.

Opmerking: Seedance ondersteunt zowel Chinese als Engelse prompts, hoewel Engelse prompts doorgaans een nauwkeurigere camerabewegingscontrole opleveren. Het wordt aanbevolen om Engels te gebruiken voor bewegings- en cameragerelateerde beschrijvingen, terwijl Chinees kan worden gebruikt voor atmosferische en stilistische beschrijvingen.

Stap vier: Parameters selecteren

Configureer generatie-instellingen:

| Parameter | Aanbevolen waarde | Beschrijving |

|---|---|---|

| Model | Seedance 2.0 | Optimale beeldkwaliteit voor het genereren van beeld naar video |

| Duur | 5 seconden (voor eerste proeven) | Begin kort, dan langer; genereer uitgebreidere versies als u tevreden bent |

| Beeldverhouding | Overeenkomstig afbeelding | 16:9 voor liggend, 9:16 voor staand, 1:1 voor vierkant |

| Resolutie | 1080p | Selecteer altijd de hoogst beschikbare resolutie |

Geavanceerde techniek: Genereer eerst een versie van 5 seconden. Als de beweging en stijl naar wens zijn, gebruik dan dezelfde prompt om een langere versie te genereren (8-15 seconden). Deze aanpak bespaart credits tijdens de verkenningsfase.

Stap vijf: genereren, controleren, herhalen

Klik op Genereren en wacht 1 tot 3 minuten. Zodra de resultaten verschijnen, evalueer je ze aan de hand van de volgende criteria:

- Is de beweging vloeiend en natuurlijk?

- Blijft het onderwerp gedurende de hele video visueel consistent?

- Komt de camerabeweging overeen met uw verwachtingen?

- Zijn er visuele onvolkomenheden (flikkering, vervorming, vervorming)?

- Komt de videokwaliteit overeen met het originele beeldmateriaal?

Als een aspect onbevredigend blijkt, pas dan de prompt aan en genereer opnieuw. Veelgebruikte aanpassingsmethoden zijn onder meer:

- Te snel? Voeg 'langzaam', 'voorzichtig', 'geleidelijk' toe aan de bewegingsbeschrijving

- Verkeerde camerarichting? ** Geef duidelijker aan: "statische camera, geen camerabeweging" of "langzame dolly-in"

- Onvolkomenheden in het gezicht? Vereenvoudig de beweging: verminder het aantal gelijktijdig uitgevoerde handelingen

- **Te weinig dynamiek? ** Gebruik dynamische werkwoorden: "zwaaien", "stromen", "drijven", "verschuiven"

Na twee of drie iteratierondes krijg je een video van hoge kwaliteit die je beelden tot leven brengt.

Begin nu met het maken van je eerste afbeelding-naar-videoclip -->

8 belangrijke toepassingen en voorbeelden van conversie van grote afbeeldingen naar video

TuSheng Video AI is geen eendagsvlieg. Het dient tientallen creatieve en commerciële doeleinden. Hieronder vindt u acht hoogwaardige toepassingsscenario's, compleet met praktische prompts die direct kunnen worden gekopieerd en aangepast.

- Portretanimatie

Breng je foto's tot leven. Portrait Animation is de populairste app om foto's om te zetten in video's. Upload je profielfoto, selfie of afbeelding van een personage en voeg vervolgens subtiele, levensechte animaties toe, zoals ademen, knipperen, het hoofd draaien, verschillende gezichtsuitdrukkingen en haarbewegingen.

Geschikt voor herdenkingsvideo's, content voor sociale media, het maken van virtuele avatars en creatieve storytelling. Op TikTok en Xiaohongshu blijft content met 'tot leven gekomen foto's' een constante trekpleister voor bezoekers.

Een statisch portret verandert in een levensechte video – natuurlijke oogbewegingen, subtiele hoofdbewegingen en golvend haar, het effect is verrassend levensecht.

Voorbeeldprompt:

The person looks directly at the camera with a calm, confident

expression. They slowly tilt their head slightly to the left and

give a subtle warm smile. Eyes blink naturally. A soft breeze gently

moves their hair. Shallow depth of field with softly blurred

background. Warm natural lighting. Cinematic portrait quality.- Productpresentatie

Transformeer productfotografie in dynamische commerciële content. Dit is revolutionair voor e-commerce merken en influencers – u beschikt al over honderden of zelfs duizenden productafbeeldingen, en nu kan elke afbeelding een videoadvertentie worden, een uitgelichte afbeelding voor productdetailpagina's of een korte film voor sociale media.

Op de productdetailpagina's van Taobao en JD.com, in livestream-productintroducties op Douyin en in productaanbevelingen op Xiaohongshu behalen dynamische productweergaven consequent aanzienlijk hogere conversiepercentages dan statische afbeeldingen.

Een standaard productafbeelding wordt opgewaardeerd tot het niveau van een hoogwaardige commerciële advertentie, met camerabewegingen, dramatische belichting en vloeiende bewegingen. Een traditionele productie hiervan zou honderden tot duizenden euro's kunnen kosten.

Voorbeeldprompt:

The camera slowly orbits 90 degrees around the product, revealing

its form from multiple angles. Soft directional studio lighting

with subtle caustic reflections on the surface. A gentle highlight

sweep moves across the product. Clean, premium commercial aesthetic.

Shallow depth of field. Ultra-smooth camera movement. 4K quality.3. Schilderachtige time-lapse

Verander landschapsfoto's in sfeervolle time-lapse-video's. Wolken trekken voorbij aan de hemel, water stroomt, het licht verandert van goudkleurig naar blauwachtig en bladeren waaien in de wind. Ideaal voor reiscontent, luchtfoto's van onroerend goed en sfeervolle B-roll-beelden.

Landschapsfotografen en reisvloggers op Bilibili kunnen hun geselecteerde foto's direct omzetten in boeiende time-lapsevideo's, waardoor de productiekosten aanzienlijk worden verlaagd.

Een landschapsfoto omgezet in een filmische time-lapse – stromende wolken, kabbelend water en wisselend licht en schaduw – waardoor een dynamische, sfeervolle kwaliteit ontstaat uit één enkel statisch beeld.

Voorbeeldprompt:

Time-lapse effect. Clouds move steadily across the sky from left

to right. Water in the foreground ripples and flows gently. Light

shifts subtly as if the sun is moving, creating slowly changing

shadows on the landscape. Trees and grass sway gently in the wind.

Camera remains static on a tripod. Serene, majestic atmosphere.

Cinematic landscape quality.4. Content voor sociale media

Zet je best presterende statische posts om in videocontent die mensen doet stoppen met scrollen. Algoritmen op platforms zoals TikTok, Xiaohongshu, Bilibili en Kuaishou geven allemaal sterk de voorkeur aan videocontent: een goed presterende afbeeldingspost krijgt bijna altijd meer verkeer wanneer deze wordt omgezet in video.

Voor makers van content op Xiaohongshu geldt dat als een reeks berichten met afbeeldingen en tekst een bijbehorende video heeft, de zichtbaarheid drie tot vijf keer zo groot kan worden. Douyin en Kuaishou werken echter volledig met video als hun belangrijkste contentformaat.

Voorbeeldprompt:

Dynamic, attention-grabbing motion. The subject moves confidently

toward the camera with energy and presence. Background elements

shift with parallax depth effect. Quick, punchy camera push-in

that creates impact. Vibrant colors, high contrast. Bold,

eye-catching aesthetic optimized for social media. Vertical 9:16.- Kunst en illustratie-animatie

Breng kunstwerken, illustraties, digitale schilderijen en grafische ontwerpen tot leven. Dit toepassingsscenario is erg populair bij kunstenaars, gameontwerpers en creatieve teams die hun werk op een boeiendere manier willen presenteren.

Binnen de kunst- en anime-gemeenschappen van Bilibili en Xiaohongshu zijn geanimeerde illustraties zeer populaire content. Door statische kunstwerken om te zetten in video's in de stijl van 'levend behang' worden ze vaak aanzienlijk vaker gedeeld en opgeslagen dan de originele afbeeldingen.

Voorbeeldprompt:

The illustrated scene comes to life with gentle, painterly motion.

Characters move subtly within their positions -- breathing, shifting

weight, small gestures. Background elements like leaves, clouds,

or particles drift slowly. The artistic style is preserved exactly

as painted. Movement is smooth and dreamlike, like a living painting.

Gentle ambient lighting shifts. Fantasy illustration quality.6. Virtuele bezichtigingen van onroerend goed

Zet foto's van onroerend goed om in virtuele rondleidingvideo's. Makelaars kunnen meeslepende previews maken met bestaande foto's van onroerend goed, waardoor het niet meer nodig is om speciale fotografieteams in te schakelen voor fotoshoots ter plaatse.

Voor vastgoedadvertenties die worden weergegeven op platforms zoals Ke.com en Anjuke, evenals vastgoedpromoties in feeds op sociale media en op Xiaohongshu, laten dynamische videobeelden een aanzienlijk hogere conversieratio van klantvragen zien.

Voorbeeldprompt:

Smooth virtual walkthrough. The camera glides forward slowly into

the room, revealing the space with a wide-angle perspective.

Natural daylight streams through the windows, casting soft shadows.

Subtle dust particles float in the sunbeams. The camera pans

gently to the left, showing the full room layout. Clean, bright,

aspirational real estate aesthetic. Steady, professional movement.- Mode- en stylingpresentatie

Creëer dynamische modecontent op basis van studiofoto's van outfits. Modellen bewegen, stoffen vallen natuurlijk, terwijl de esthetische stijl van het redactieniveau behouden blijft.

Xiaohongshu-modebloggers en Taobao-kledingverkopers kunnen grote hoeveelheden bestaande modellenfoto's en platte outfitfoto's omzetten in dynamische displayvideo's, waardoor ze een grotere visuele impact hebben binnen informatiefeeds.

Voorbeeldprompt:

The model strikes a confident pose and then slowly shifts their

weight, creating natural body movement. Fabric of the outfit

flows and catches the light with each subtle motion. Wind effect

gently moves the hair. Camera starts at full body and slowly drifts

upward to a waist-up shot. High-fashion editorial lighting with

strong directional shadows. Vogue magazine aesthetic. Cinematic

slow motion.- Educatieve en verklarende inhoud

Verander statische grafieken, infographics en educatieve illustraties in dynamische presentaties. Complexe concepten worden gemakkelijker te begrijpen wanneer ze in beweging worden gezet.

Makers op Bilibili's Knowledge Zone en verschillende educatieve platforms kunnen cursusmateriaal, diagrammen en stroomdiagrammen omzetten in geanimeerde video's, waardoor de effectiviteit van het onderwijs en het behoud van kijkers aanzienlijk worden verbeterd.

Voorbeeldprompt:

The diagram elements animate sequentially. Arrows begin to flow

in their indicated directions. Labels fade in one by one. Moving

parts of the system activate in logical order, showing the process

step by step. Smooth transitions between stages. Clean, clear

educational style. Elements highlight with subtle glow as they

become active. Professional presentation quality.Tusheng-videoprompttechnieken: de complete gids

Een goed opgestelde prompt is de meest effectieve vaardigheid bij het genereren van afbeeldingen op basis van foto's. Aangezien de AI uw afbeelding al heeft gezien, moet uw prompt volledig gericht zijn op beweging en dynamiek. Hier volgen enkele technieken die de beste resultaten opleveren.

Snelgids met sportgerelateerde trefwoorden

Gebruik deze specifieke trefwoorden om de beweging van de video nauwkeurig te regelen.

| Bewegingstype | Trefwoorden | Effect | |-------- -|-------|------| | Camera: vooruit | inzoomen, dichterbij komen, naderen | Camera beweegt naar onderwerp toe | | Camera: achteruit | uitzoomen, terugtrekken, afstand nemen, verbreden | Camera beweegt weg van onderwerp | | Opname: links/rechts | pan naar links, pan naar rechts, track naar links, track naar rechts | Camera draait of trackt horizontaal | | Opname: omhoog/omlaag | kantelen omhoog, kantelen omlaag, kraan omhoog, kraan omlaag | Camera draait of beweegt verticaal | | Opname: Orbit | cirkelen, ronddraaien, ronddraaien, boog | Camera cirkelt rond onderwerp | | Camera: Zoom | inzoomen, uitzoomen, brandpuntsafstand verschuiven | Zoomen (zonder verplaatsing) | | Onderwerp: Microbewegingen | ademen, knipperen, gewicht verplaatsen, microbewegingen | Subtiele, levensechte beweging | | Onderwerp: Matig | hoofd draaien, glimlachen, gebaren, langzaam lopen | Duidelijke maar gecontroleerde beweging | | Onderwerp: Dynamisch | rennen, springen, dansen, draaien, zwaaien | Energieke beweging van het hele lichaam | | Omgeving: Zacht | briesje, drijven, wiegen, rimpelen, glinsteren | Zachte omgevingsbeweging | | Omgeving: Intens | waaien, razen, beuken, wervelen, stromen | Sterke omgevingsdynamiek | | Parallax | parallax, diepteverschuiving, lagen bewegen | Voorgrond/achtergrond bewegen met verschillende snelheden |

Verschillende trefwoorden voor camerabewegingen produceren totaal verschillende effecten. Kies uw camerabewegingstechniek zorgvuldig op basis van het gewenste resultaat.

Snelheid en tempocontrole

Het tempo van de beweging heeft een grote invloed op de emotionele toon van een video. Gebruik de volgende aanpassingen:

- Extreem langzaam: "nauwelijks waarneembaar", "ultra-slow motion", "gletsjertempo" — dramatisch, contemplatief

- Langzaam: "langzaam", "zachtjes", "geleidelijk", "ontspannen" — elegantie, filmische kwaliteit

- Matig: "stabiel", "natuurlijk tempo", "op loopsnelheid" — realisme, documentaire stijl

- Snel: " snel", "levendig", "energiek", "vlug" — dynamisch, opwindend

- Extreem snel: "razendsnel", "whip pan", "snelle montage", "uitbarsting van beweging" — spannend, vol actie

Geavanceerde techniek: Gebruik standaard slow motion. In door AI gegenereerde video's ziet slow motion er bijna altijd beter uit dan fast motion. Snelle bewegingen verhogen het risico op fouten en visuele inconsistenties.

Onafhankelijke bewegingscontrole van achtergrond en onderwerp

Je kunt zelf bepalen wat beweegt en wat stil blijft staan. Dit is een krachtige techniek om de aandacht van het publiek te sturen.

Onderwerp in beweging, achtergrond in rust:

The person walks forward confidently while the background remains

perfectly still. Static camera, no camera movement. Focus entirely

on the subject's motion.Dynamische achtergrond, statisch onderwerp:

The person stands completely still, like a statue. Behind them,

clouds drift across the sky, leaves blow in the wind, and city

lights flicker. Only the environment moves.Afzonderlijke bewegingen van beide partijen:

The person slowly turns their head while the camera simultaneously

dollies in. Background clouds drift in the opposite direction,

creating a sense of depth and dimension.Het verschil tussen camerabeweging en objectbeweging

Het begrijpen van het verschil tussen camerabeweging en objectbeweging is cruciaal om het gewenste effect te bereiken.

Camerabewegingen veranderen het perspectief en de compositie. De scène zelf blijft onbeweeglijk, terwijl het gezichtspunt verschuift. Wordt gebruikt om: de scène te onthullen, de setting te schetsen en dramatische nadruk te leggen.

Objectbeweging verwijst naar de beweging van elementen binnen een scène terwijl de camera stil blijft staan. Het wordt gebruikt voor: karakteranimatie, productdemonstraties en natuurlijke omgevingsdynamiek.

Gecombineerde bewegingen maken gebruik van beide tegelijkertijd. Dit is de meest filmische techniek, maar ook de meest uitdagende voor AI om goed uit te voeren. Het is raadzaam om eerst één type beweging onder de knie te krijgen en pas een andere toe te voegen als je tevreden bent met het resultaat.

Geavanceerde promptstructuren

Om de meest voorspelbare resultaten te behalen, organiseer je je prompt in de volgende volgorde:

- Primaire actie — Wat het hoofdonderwerp doet

- Camerabeweging — Hoe de camera beweegt

- Omgevingsdynamiek — Wat omgevingselementen doen

- Snelheid/Tempo — Het tempo van alle bewegingen

- Sfeer/stemming — Emotionele toon

- Verbetering van de visuele kwaliteit — Technische beschrijving van de visuele kwaliteit

Voorbeeld van het gebruik van deze structuur:

[Subject] A young woman in a flowing white dress slowly raises

her hand to brush hair from her face.

[Camera] The camera executes a slow, steady dolly in from a

medium shot to a close-up.

[Environment] Cherry blossom petals drift gently through the

air. Soft golden sunlight filters through the trees.

[Speed] All motion is slow and deliberate, almost dreamlike.

[Mood] Romantic, ethereal, peaceful atmosphere.

[Quality] Cinematic shallow depth of field, anamorphic bokeh,

film grain, 4K quality.2026 TuSheng Video AI-toolsvergelijking

De concurrentie in de sector van videostreaming wordt steeds heviger. Hieronder volgt een vergelijkende analyse van de belangrijkste platforms in februari 2026, met bijzondere aandacht voor de toegankelijkheid voor gebruikers op het Chinese vasteland.

De verwerkingseffecten van dezelfde bronafbeelding op vijf verschillende videogeneratieplatforms. Verschillen in bewegingskwaliteit, temporele consistentie en visuele getrouwheid zijn onmiddellijk zichtbaar.

| Functie | Seedance 2.0 | Runway Gen-4 | Pika 2.0 | Kling 3.0 | Luma Dream Machine | |------|-------------|-------------|---------|------ ----------|-------------------| | Maximale resolutie | 2K (2048x1080) | 4K (opgeschaald) | 1080p | 1080p | 1080p | | Maximale duur | 15 seconden | 10 seconden | 5 seconden | 2 minuten | 5 seconden | | Invoeropties | Afbeelding + tekst + video + audio | Afbeelding + tekst + video | Afbeelding + tekst | Afbeelding + tekst | Afbeelding + tekst | | Invoer van meerdere afbeeldingen | Ondersteund (maximaal 9 afbeeldingen) | Niet ondersteund | Niet ondersteund | Niet ondersteund | Niet ondersteund | | Native audio | Ondersteund (8 talen met lipsynchronisatie) | Niet ondersteund | Gedeeltelijk (geluidseffecten) | Niet ondersteund | Niet ondersteund | | Camerabesturing | Op prompts gebaseerd | Motion Brush + Director Mode | Basis | Basis | Op prompts gebaseerd | | Gratis quota | Beschikbaar (inbegrepen bij registratie) | Beschikbaar (beperkt) | Beschikbaar (beperkt) | Beschikbaar (beperkt) | Beschikbaar (beperkt) | | Startprijs | ~$9,90/maand | $15/maand | $10/maand | ~$6,99/maand | $9,99/maand | | Toegang vanuit het Chinese vasteland | Direct toegankelijk | VPN vereist | VPN vereist | Direct toegankelijk | VPN vereist | | Meest geschikt voor | Multimodale bediening, beeldkwaliteit | Professionele bewerkingsworkflow | Beginners, leuke effecten | Lange video's, hoge waarde | Filmisch gevoel, 3D-scènes |

Gedetailleerde beoordelingen van elke tool

Seedance 2.0 is ongeëvenaard wat betreft invoerflexibiliteit. Het is het enige platform dat gelijktijdige uploads van maximaal negen referentieafbeeldingen, audio-invoer met lipsynchronisatie en het combineren van alle invoermodi binnen één generatie ondersteunt. Als u maximale controle wilt over de uitvoer van afbeeldingen naar video, biedt Seedance de meest uitgebreide toolkit. De uitvoer met een resolutie van 2K is ook de hoogste van alle tools (zonder gebruik te maken van upsampling). Ontwikkeld door ByteDance (moederbedrijf van TikTok), hebben gebruikers op het Chinese vasteland direct toegang zonder dat ze een VPN of buitenlandse betaalmethoden nodig hebben.

Runway Gen-4 blinkt uit in nauwkeurige controle. Met Motion Brush kunt u nauwkeurig 'schilderen' welke delen van een afbeelding moeten bewegen en in welke richting. Als u chirurgische precisie nodig hebt voor specifieke gebieden, is Runway de beste keuze. De nadelen zijn de hogere prijs en lagere generatiequota. Voor toegang binnen China is een VPN vereist.

Pika 2.0 is de meest toegankelijke optie. Voor beginners die willen experimenteren met het genereren van afbeeldingen naar video's zonder zich te verdiepen in prompt engineering, bieden de effecten met één klik en de gestroomlijnde interface van Pika de laagste instapdrempel. Hoewel de beeldkwaliteit niet zo goed is als die van premium tools, is deze voldoende voor informele sociale content. Vereist een VPN voor toegang binnen China.

Kling 3.0 overtreft zijn concurrenten ruimschoots, zowel wat betreft looptijd als prijs-kwaliteitverhouding. Als u langere video's wilt maken – van 30 seconden, 1 minuut of zelfs 2 minuten – op basis van één afbeelding, dan is Kling de enige haalbare optie. De prijs-kwaliteitverhouding is uitzonderlijk gunstig. De beperking ligt in de beperkte invoeropties (één afbeelding + tekst). Als product onder de paraplu van Kuaishou is Kling rechtstreeks toegankelijk in het vasteland van China, waardoor binnenlandse gebruikers nog een naadloze optie krijgen.

Luma Dream Machine blinkt uit in ruimtelijk inzicht. Voor landschappen, architectuur en scènes waar driedimensionaal ruimtelijk inzicht cruciaal is, produceert Luma de meest overtuigende parallax- en camerabewegingen. De karakteranimatie blijft achter bij die van concurrenten. Voor toegang vanuit het binnenland is een VPN vereist.

Aanbevelingen voor gebruikers op het Chinese vasteland

Als u zich op het Chinese vasteland bevindt, zijn er hoofdzakelijk twee videotools die direct zonder VPN kunnen worden gebruikt:

- Seedance 2.0 — Ontwikkeld door ByteDance, volledig functioneel en klaar voor gebruik, met multimodale invoer + 2K-resolutie + geïntegreerde audio

- Kling 3.0 — Een product van Kuaishou, uitblinker in het genereren van lange video's met een uitstekende prijs-kwaliteitverhouding

Hoewel buitenlandse tools zoals Runway, Pika en Luma elk hun eigen onderscheidende kenmerken hebben, vereisen ze allemaal VPN-toegang en buitenlandse betaalmethoden, wat een hogere toegangsdrempel oplevert.

Voor makers van content op binnenlandse platforms zoals Douyin, Xiaohongshu, Bilibili en Kuaishou biedt de keuze voor tools die rechtstreeks toegankelijk zijn binnen China niet alleen meer gemak, maar ook een betrouwbaardere netwerkstabiliteit en betalingsgemak.

Voor een uitgebreidere vergelijking (inclusief tekst-naar-video-mogelijkheden) verwijzen wij u naar onze 2026 AI Video Generator Complete Ranking.

Veelvoorkomende fouten en correctiemethoden

Na het testen van duizenden videoclips zijn dit de vijf meest voorkomende fouten die we hebben waargenomen, samen met specifieke corrigerende maatregelen.

- Gebruik stockfoto's met een lage resolutie

De gemaakte fout: Een kleine, gecomprimeerde afbeelding uploaden (zoals een miniatuurafbeelding van 400x300 die is opgeslagen vanuit WeChat of sociale media) terwijl je een video met hoge resolutie verwacht.

Waarom het niet werkt: De encoder kan onvoldoende visuele informatie uit afbeeldingen met een lage resolutie halen. De uitvoer blijft wazig en er ontstaan ook bewegingsartefacten.

Oplossing: Gebruik altijd de versie van de afbeelding met de hoogste resolutie. Als er alleen versies met een lage resolutie beschikbaar zijn, gebruik dan een AI-upscalingtool (zoals Real-ESRGAN of Topaz Gigapixel) om de resolutie te verbeteren voordat u de afbeelding uploadt. De minimaal aanbevolen grootte is 1024 x 1024 pixels.

- Schrijf scènebeschrijvingen in plaats van actieomschrijvingen

De gemaakte fout: Schrijfopdrachten zoals "Het zeeoppervlak bij zonsondergang, met gouden licht dat op het water glinstert." Dit beschrijft het uiterlijk van het beeld – iets wat de AI al weet.

Waarom het mislukte: De AI heeft de afbeelding al gecodeerd. Door de inhoud van de afbeelding opnieuw te beschrijven, wordt promptruimte verspild aan overbodige informatie en wordt geen richting gegeven voor beweging.

Hoe te herzien: Richt de prompt volledig op de beweging. Herschrijf als volgt: "Golven rollen zachtjes naar de kust. Gouden zonlicht glinstert op het wateroppervlak. Wolken drijven langzaam van links naar rechts. De camera draait langzaam naar rechts en volgt de kustlijn."

- Te veel acties tegelijkertijd uitvoeren

Gemaakte fouten: "Het personage draait zich om, zwaait, loopt naar voren, pakt een kopje, glimlacht en danst, terwijl de camera inzoomt, naar links draait en kantelt."

Waarom het niet werkt: De huidige AI-modellen kunnen niet op betrouwbare wijze meer dan twee of drie gelijktijdige acties coördineren. Overbelaste prompts zorgen ervoor dat het model de meeste instructies negeert of verwarde, foutieve resultaten produceert.

Hoe te bewerken: Beperk elke generatie tot één primaire actie van het onderwerp plus één camerabeweging. Voor complexe, doorlopende acties kunt u het beste meerdere korte clips afzonderlijk genereren voordat u ze bewerkt en aan elkaar plakt.

- Negeer afwijkingen in beeldverhouding

De gemaakte fout: Een landschapsfoto uploaden in een beeldverhouding van 16:9, maar de uitvoer instellen op een staande beeldverhouding van 9:16, of vice versa.

Waarom het niet werkt: AI snijdt je afbeelding drastisch bij of vereist het opvullen van grote lege gebieden. Geen van beide benaderingen levert bevredigende resultaten op: bijsnijden doet afbreuk aan een zorgvuldig samengestelde compositie, terwijl het opvullen van grote nieuwe gebieden inconsistenties veroorzaakt.

Oplossing: Zorg ervoor dat de beeldverhouding van de uitvoer overeenkomt met de verhoudingen van de bronafbeelding. Gebruik 16:9 voor afbeeldingen in liggend formaat en 9:16 voor afbeeldingen in staand formaat. Als een andere beeldverhouding vereist is, snijd de bronafbeelding dan bij tot de gewenste verhoudingen voordat u deze uploadt.

- Een fotorealistisch effect verwachten van een illustratie

De gemaakte fout: Een cartoonillustratie of platte ontwerpafbeelding uploaden, in de verwachting dat de AI fotorealistische videobeelden zou genereren.

Waarom het niet werkt: Het model probeert artistieke stijlen te interpreteren, waardoor er soms ongewenst realisme ontstaat. Vlakke illustraties missen de diepte en lichtinvloeden waarop het model zich baseert voor het voorspellen van natuurlijke bewegingen.

Hoe te verhelpen: Als het bronmateriaal een illustratie is, vermeld dan expliciet de stijl in de prompt: "Behoud de geïllustreerde kunststijl exact. Geanimeerd in een 2D-animatiestijl, niet fotorealistisch. Bewegingen moeten handgetekend en schilderachtig aanvoelen." Dit instrueert het model om de artistieke stijl te behouden in plaats van fotorealisme te introduceren.

Veelgestelde vragen

Welke AI-tool is het meest geschikt voor het genereren van video's op basis van afbeeldingen?

Seedance 2.0 is onze topaanbeveling voor generatieve video in 2026. Het ondersteunt meerdere beeldinvoer (tot 9 referentiebeelden), uitvoer met een resolutie van 2K en biedt de meest flexibele combinaties van beelden, tekst, video en audio. Bovendien is Seedance, ontwikkeld door ByteDance, rechtstreeks toegankelijk binnen het Chinese vasteland. Voor prijsbewuste gebruikers biedt Kling 3.0 uitstekende beeldkwaliteit tegen een lagere prijs, ook direct toegankelijk binnen het Chinese vasteland. Voor beginners biedt Pika 2.0 de eenvoudigste interface. De optimale keuze hangt af van uw specifieke vereisten. Raadpleeg onze [toolvergelijkingstabel](#2026-year image-to-video AI tool comparison).

Kan TuSheng Video gratis worden gebruikt?

Zeker. Meerdere platforms bieden gratis quota aan. Seedance biedt gratis credits aan elke nieuwe gebruiker, zonder dat een creditcard nodig is. Pika 2.0 en Luma Dream Machine bieden ook een beperkte gratis generatie aan. HaiLuo AI biedt dagelijks 10 gratis generaties aan. Deze gratis quota zijn voldoende om de technologie te testen en verschillende video's te produceren. Voor continu gebruik zijn betaalde abonnementen voordeliger. Raadpleeg onze Seedance Free Usage Guide voor meer strategieën voor gratis gebruik.

Wat is de maximale lengte voor door AI gegenereerde video's?

Verschillende platforms hebben verschillende limieten. Kling 3.0 loopt voorop en genereert video's van maximaal 2 minuten per afbeelding. Seedance 2.0 heeft een limiet van 15 seconden. Runway Gen-4 heeft een maximum van 10 seconden. Pika 2.0 en Luma Dream Machine beperken video's tot 5 seconden. Voor de meeste sociale media en marketing scenario's is 5-15 seconden de optimale duur. Als er langere beelden nodig zijn, kan men meerdere korte clips genereren voor latere bewerking en samenvoeging, of Kling gebruiken voor het genereren van lange video's uit één opname.

Welk afbeeldingsformaat is het meest geschikt voor het genereren van AI-video's?

PNG is optimaal omdat het een verliesvrij formaat is, zonder compressieartefacten. WebP (verliesvrije modus) bereikt gelijkwaardige resultaten met kleinere bestandsgroottes. JPG is in de meeste gevallen ook geschikt, maar sterk gecomprimeerde JPG's met zichtbare artefacten zullen de uitvoerkwaliteit verminderen. Vermijd het gebruik van GIF, BMP of andere niet-standaardformaten. Alle grote platforms ondersteunen JPG, PNG en WebP. Minimale resolutie: 512x512 pixels. Aanbevolen: 1024x1024 of hoger.

Kan AI elk type afbeelding animeren?

AI kan de meeste soorten afbeeldingen animeren, hoewel de resultaten variëren afhankelijk van het onderwerp. Portretten en close-ups leveren de beste resultaten op: de huidige modellen interpreteren natuurlijke gezichtsbewegingen en haargroei nauwkeurig. Landschappen en natuurlijke scènes presteren ook uitzonderlijk goed, met overtuigende weergaven van wolkenbewegingen, stromend water en wuivende vegetatie. Productafbeeldingen met een strakke achtergrond leveren consistent betrouwbare resultaten op. Illustraties en kunstwerken kunnen worden geanimeerd, hoewel er mogelijk aangepaste stilistische aanwijzingen nodig zijn om onbedoeld fotorealisme te voorkomen. Complexe groepsscènes, afbeeldingen met veel tekst en foto's van lage kwaliteit leveren de minst stabiele resultaten op.

Wat is het verschil tussen beeldgegenereerde video en tekstgegenereerde video?

Tekst-naar-video genereert zowel visuele inhoud als beweging tegelijkertijd op basis van tekstuele beschrijvingen. De AI bepaalt het volledige visuele uiterlijk, waardoor u minder controle hebt over specifieke details, maar meer creatieve vrijheid hebt. Afbeelding-naar-video gebruikt uw bestaande afbeeldingen als uitgangspunt en genereert alleen de beweging. U behoudt nauwkeurige controle over de visuele output, aangezien u de visuele referentie levert. Image-to-Video levert doorgaans meer voorspelbare en consistente resultaten op, omdat de AI een concreet visueel ankerpunt heeft. Text-to-Video is beter geschikt om de AI volledig nieuwe content te laten creëren.

Kan Tusheng Video camerabewegingen regelen?

Zeker. De meeste moderne generatieve videotools ondersteunen het aansturen van camerabewegingen via tekstprompts. U kunt bewegingen specificeren zoals "dolly in", "pan left", "orbit around", "crane up", "zoom out" en "tracking shot". Seedance 2.0 en Luma Dream Machine reageren bijzonder nauwkeurig op deze bewegingssleutelwoorden. Runway Gen-4 biedt extra precisie door middel van Motion Brush en Director Mode, waarmee visuele paden voor cameratrajecten kunnen worden getekend. Het is raadzaam om slechts één bewegingstype per generatie te specificeren, aangevuld met snelheidsmodificatoren zoals 'langzaam' of 'gestaag'.

Is de beeldkwaliteit van door AI gegenereerde video's voldoende voor professionele toepassingen?

Voor korte videocontent (5-15 seconden) is dit heel goed mogelijk. De output van toonaangevende platforms zoals Seedance 2.0 en Runway Gen-4 wordt al professioneel gebruikt voor socialemediamarketing, e-commerceproductvideo's, vastgoedpresentaties en reclameconcepten. In eigen land bevatten belangrijke commerciële content op Douyin en Xiaohongshu nu door AI gegenereerde videomateriaal. Er zijn echter nog steeds beperkingen: langere duur verhoogt het risico op onvolkomenheden, complexe scènes met meerdere onderwerpen zijn onstabiel en de weergave van tekst in video's blijft onvolmaakt. Voor uitzendingen van uitzendkwaliteit of filmische werken die absolute perfectie vereisen, blijft traditionele filmopname de veiligere keuze. Voor digitale marketing en sociale content heeft AI-beeld-naar-videotechnologie professionele normen bereikt.

Samenvatting

TuSheng Video AI is geëvolueerd van een nieuwigheidje tot een essentieel hulpmiddel voor het creëren van content. De technologie is volwassen geworden, de tools zijn gebruiksvriendelijker geworden en de outputkwaliteit voldoet nu aan professionele normen voor de overgrote meerderheid van digitale contentscenario's.

Dit zijn de belangrijkste punten:

- De kwaliteit van de bronafbeeldingen is van cruciaal belang. Scherpe, goed gecomponeerde foto's met een hoge resolutie leveren veel betere resultaten op dan wazige foto's of foto's met een lage resolutie.

- Schrijf beweging, geen beschrijving. De AI heeft uw afbeelding al gezien. Vertel hem hoe dingen moeten bewegen, niet hoe ze eruitzien.

- **Begin eenvoudig. ** Eén actie van het onderwerp plus één camerabeweging. Beheers de basis voordat u complexiteit toevoegt.

- Herhaal snel. Genereer eerst korte testclips; produceer de volledige versie pas als u tevreden bent.

- **Stem tools af op taken. ** Seedance geeft prioriteit aan visuele getrouwheid en multimodale controle; KeLing blinkt uit in lange video's en kosteneffectiviteit; Runway richt zich op nauwkeurige bewerking; Pika benadrukt eenvoud en gebruiksgemak.

- Kies de tool die bij uw behoeften past. Als u zich op het Chinese vasteland bevindt, kunt u Seedance en KeLing direct gebruiken zonder extra netwerk- of betalingsbarrières.

De kloof tussen merken en makers die gebruikmaken van Tusheng Video AI en hun collega's die nog steeds afhankelijk zijn van statische beelden, wordt elke maand groter. Elke foto in uw productbibliotheek heeft potentieel als videoreclame. Elk portret kan een dynamische avatar worden. Elk landschap kan dienen als filmisch B-roll-materiaal.

Maak gratis je eerste afbeelding-naar-video --> — Upload een afbeelding en zie hoe deze binnen twee minuten tot leven komt. Geen creditcard nodig, direct toegankelijk in het vasteland van China.

Wilt u meer AI-videofuncties ontdekken? Ervaar Seedance op alle platforms --> — Tekst-naar-video, video-naar-video, multimodale generatie: alles op één plek.

Meer lezen: Seedance Complete User Guide | Seedance Prompt Guide met meer dan 50 voorbeelden | AI Video Creative Application Cases | Ranglijst van de beste AI-videogeneratoren voor 2026 | AI-videomarketing en socialemediagids*